Introduction

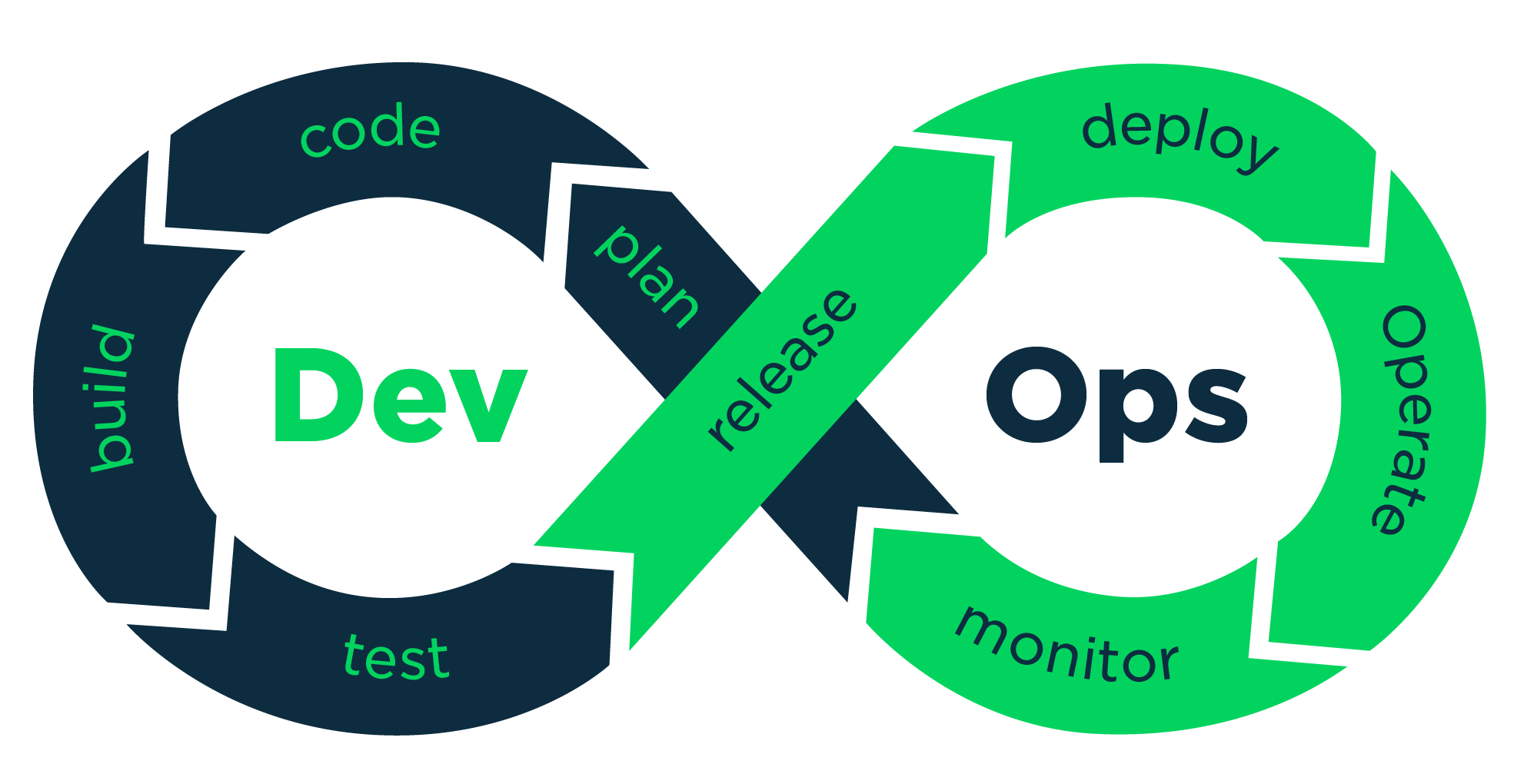

DevOps

Le nouveau paradigme de l’informatique

Supports de formation : Elie Gavoty et Hadrien Pélissier Conçus initialement dans le cadre d'un cursus Uptime Formation. Sous licence CC-BY-NC-SA - Docker - Avril 2021

Le nouveau paradigme de l’informatique

Hadrien Pélissier

“Le DevOps est un mouvement qui s’attaque au conflit existant structurellement entre le développement de logiciels et les opérations. Ce conflit résulte d’objectifs et de motivations divergents. Le DevOps améliore la collaboration entre les départements du développement et des opérations et rationalise l’ensemble de l’organisation. (Citation de Hütterman 2012 - Devops for developers)”

Traditionnellement la qualité logicielle provient :

Problèmes historiques posé par trop de spécification et validation humaine :

process formels : ennuyeux et abstraitMais l’agilité traditionnelle ne concerne pas l’administration système.

Exemple : Netflix ou Spotify ou Facebook etc. déploient une nouvelle version mineure de leur logiciel par jour.

La célérité et l’agrandissementest sont incompatibles avec une administration système traditionnelle:

Dans un DSI (département de service informatique) on organise ces activités d’admin sys en opérations:

La difficulté principale pour les Ops c’est qu’un système informatique est:

On peut donc constater que les opérations traditionnelles implique une culture de la prudence

Les opérations “traditionnelles”:

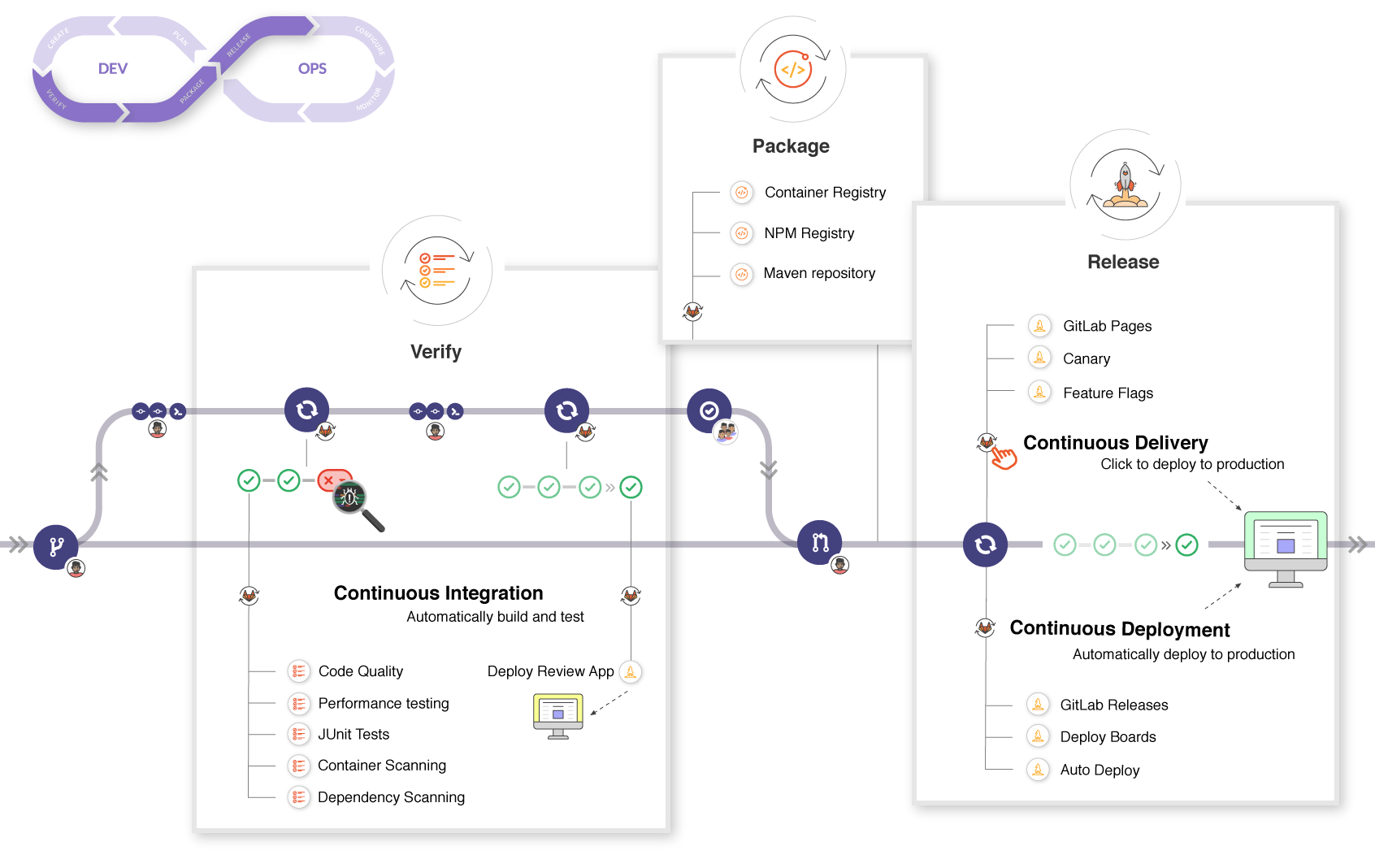

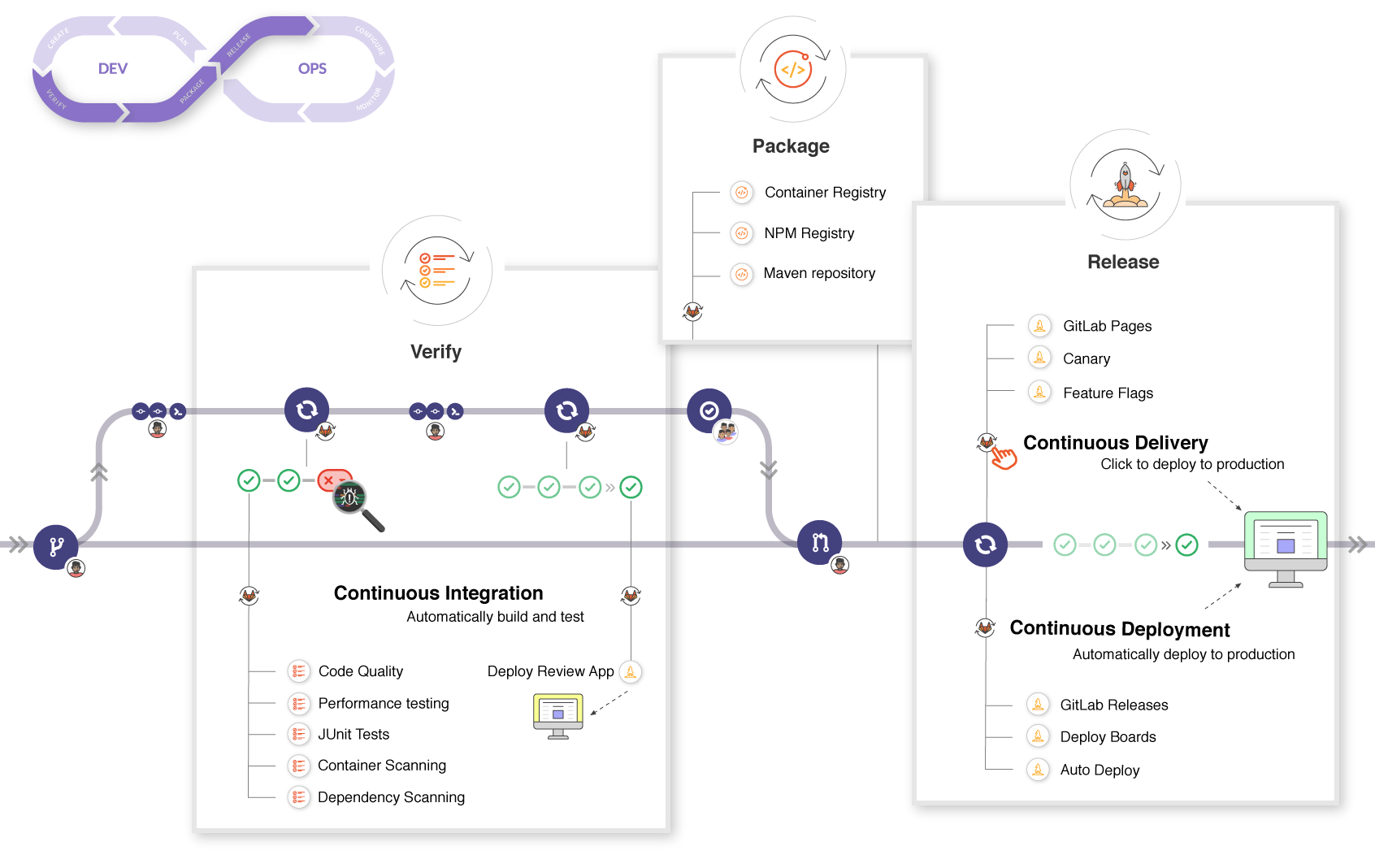

Du côté des développeur·euses avec l’agilité on a déjà depuis des années une façon d’automatiser pleins d’opérations sur le code à chaque fois qu’on valide une modification.

C’est ce qu’on appelle l’intégration continue.

Le principe central du DevOps est d’automatiser également les opérations de déploiement et de maintenance en se basant sur le même modèle.

Mais pour que ça fonctionne il faut résoudre des défi techniques nouveau => innovations

Dans le cadre d’un produit logiciel, les administrateurs systèmes sont rassemblées avec le développement et le chef produit : tout le monde fait les réunions ensemble pour se parler et se comprendre.

Les développeur·euses peuvent plus facilement créer un environnement réaliste pour jouer avec et comprendre comment fonctionne l’infrastructure de production (ils progressent dans l’administration système et la compréhension des enjeux opérationnels).

Les adminsys apprennent à programmer leurs opérations de façon puissante il deviennent donc plus proche de la logique des développeur·euses. (grace à l’Infrastructure as Code)

Par abus de langage on dit un ou une DevOps pour parler d’un métier spécifique dans une entreprise. Je dis que je suis DevOps sur mon CV par exemple.

Vous pouvez retenir :

Il faut être polyvalent : bien connaître l’administration système Linux mais aussi un peu la programmation et le développement.

Il faut connaître les nouvelles bonnes pratiques et les nouveaux outils cités précédemment.

“Machines ain’t smart. You are!” Comment dire correctement aux machines quoi faire ?

Plutôt que d'installer manuellement de nouveaux serveurs linux pour faire tourner des logiciels on peut utiliser des outils pour faire apparaître de nouveaux serveurs à la demande.

Du coup on peut agrandir sans effort l’infrastructure de production pour délivrer une nouvelle version

C’est ce qu’on appelle le IaaS (Infrastructure as a service)

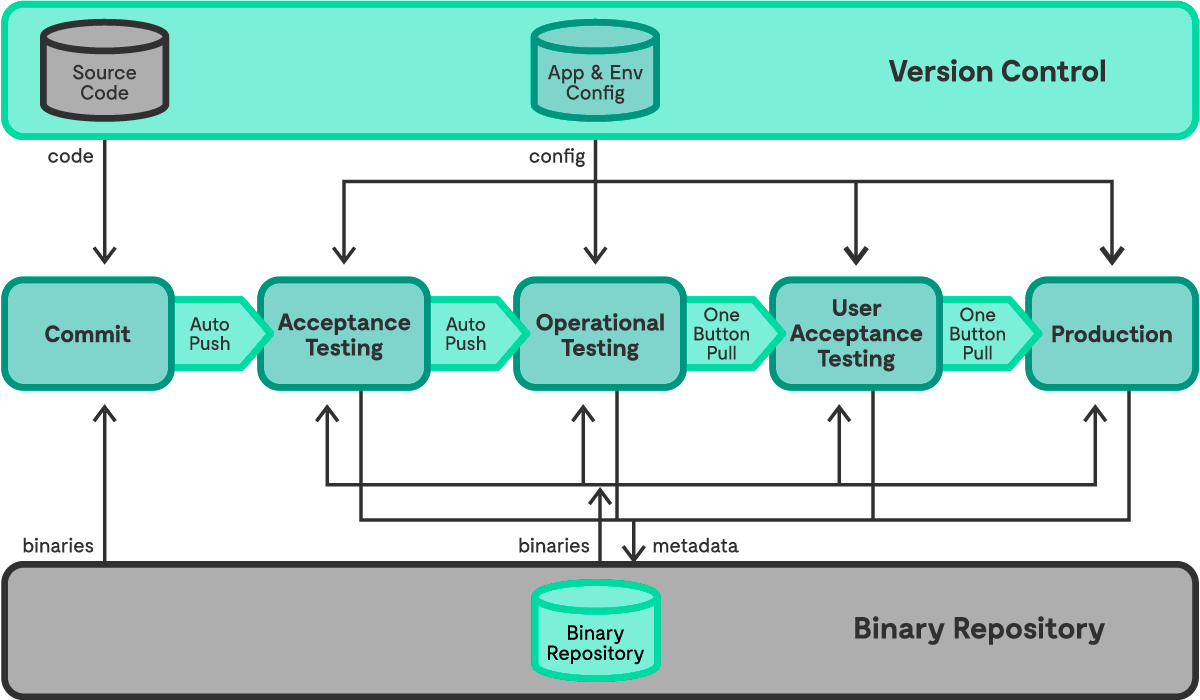

Accélérer la livraison des nouvelles versions du logiciel.

Des tests systématiques et automatisés pour ne pas se reposer sur la vérification humaine.

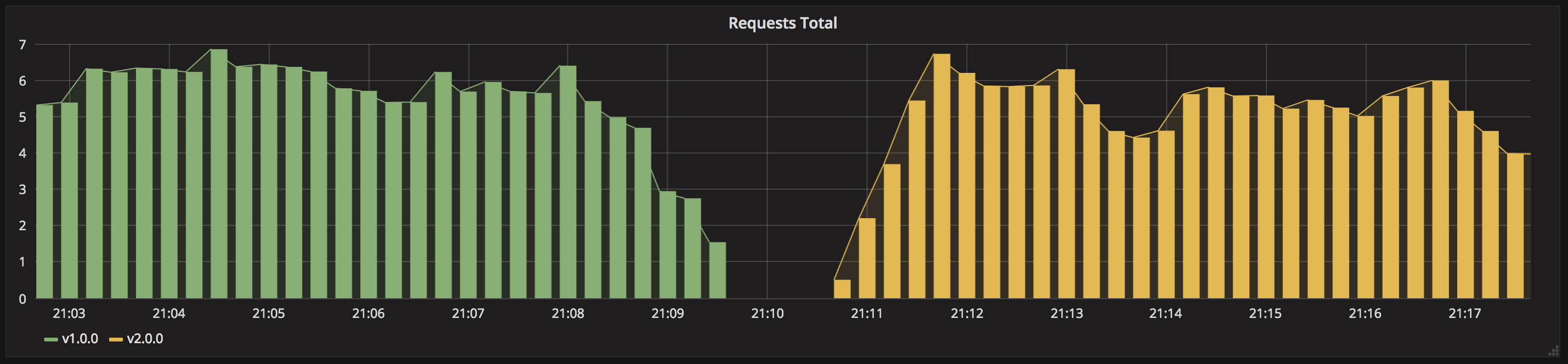

Un déploiement progressif en parallèle (Blue/Green) pour pouvoir automatiser le Rollback et être serein.

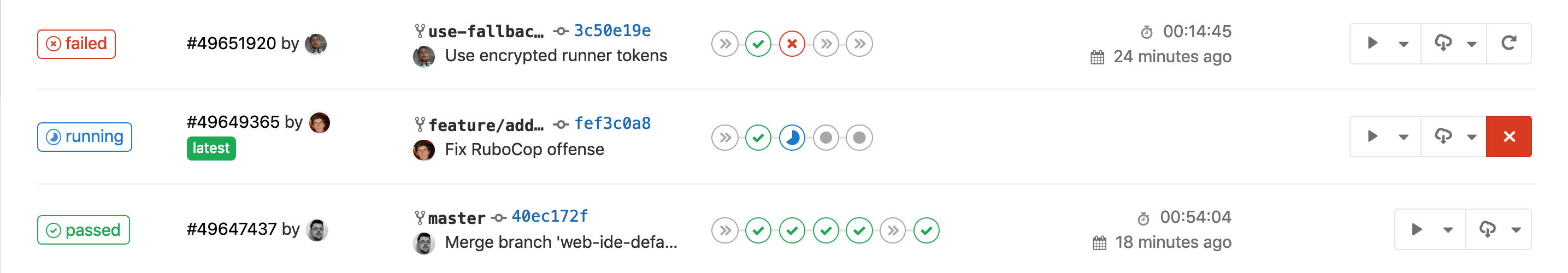

A chaque étape le code passe dans un Pipeline de validation automatique.

Permet de régler un problème de l’administration système : Difficultée l’état du système à un instant T ce qui augmente les risques.

Plutôt que d’appliquer des commandes puis d’oublier si on les a appliqué, On décrit le système d’exploitation (l’état du linux) dans un fichier et on utilise un système qui applique cette configuration explicite à tout moment.

Permet aux Ops/AdminSys de travailler comme des développeur·euses (avec une usine logicielle et ses outils)

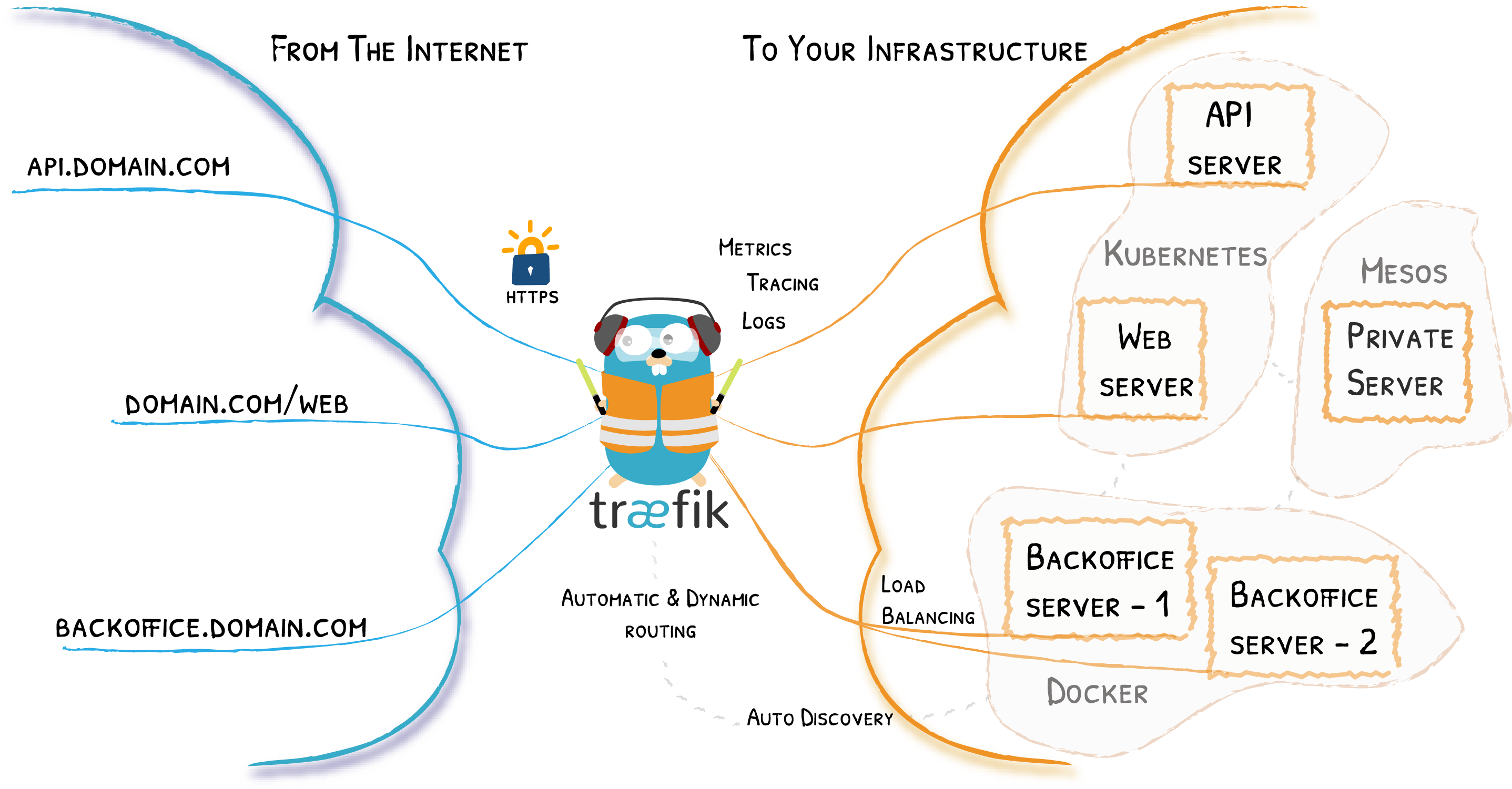

Un mouvement d’informatique lié au DevOps et au cloud :

Une façon de définir une infrastructure dans un fichier descriptif et ainsi de créer dynamiquement des services.

Assez différent de l’administration système sur mesure (= méthode de résolution plus ou moins rigoureuse à chaque nouveau bug)

Infrastructure as a Service (commercial et logiciel)

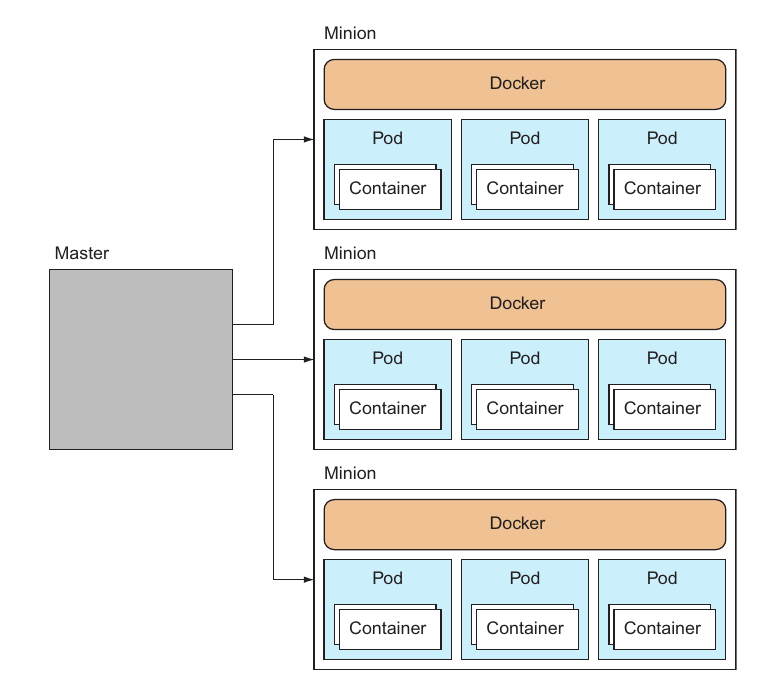

Plateform as a Service - Heroku, cluster Kubernetes Avec une offre d’hébergement de conteneurs, on parle la plupart du temps de Platform as a Service.

Il s’agit comme son nom l’indique de gérer les infrastructures en tant que code c’est-à-dire des fichiers textes avec une logique algorithmique/de données et suivis grâce à un gestionnaire de version (git).

Le problème identifié que cherche a résoudre l’IaC est un écheveau de difficulées pratiques rencontrée dans l’administration système traditionnelle:

Faire des boîtes isolées avec nos logiciels:

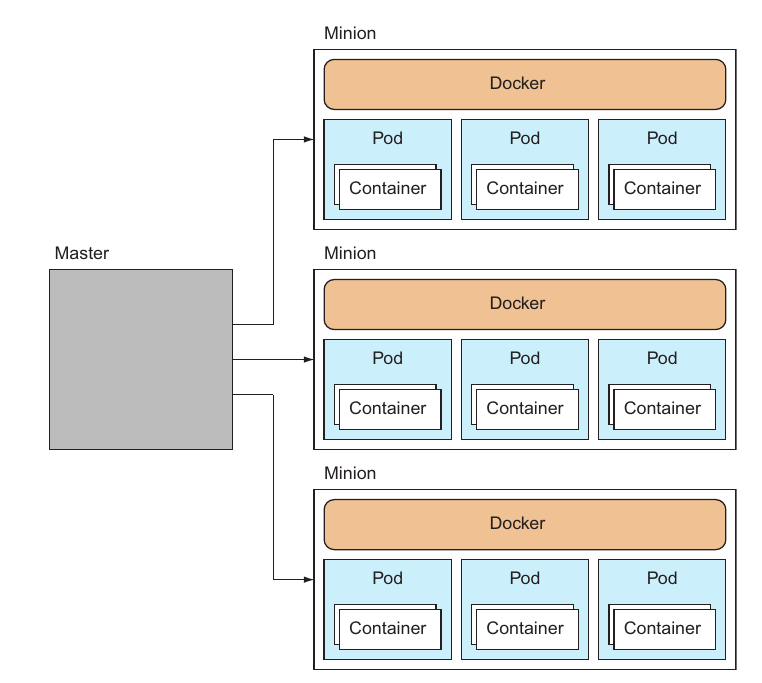

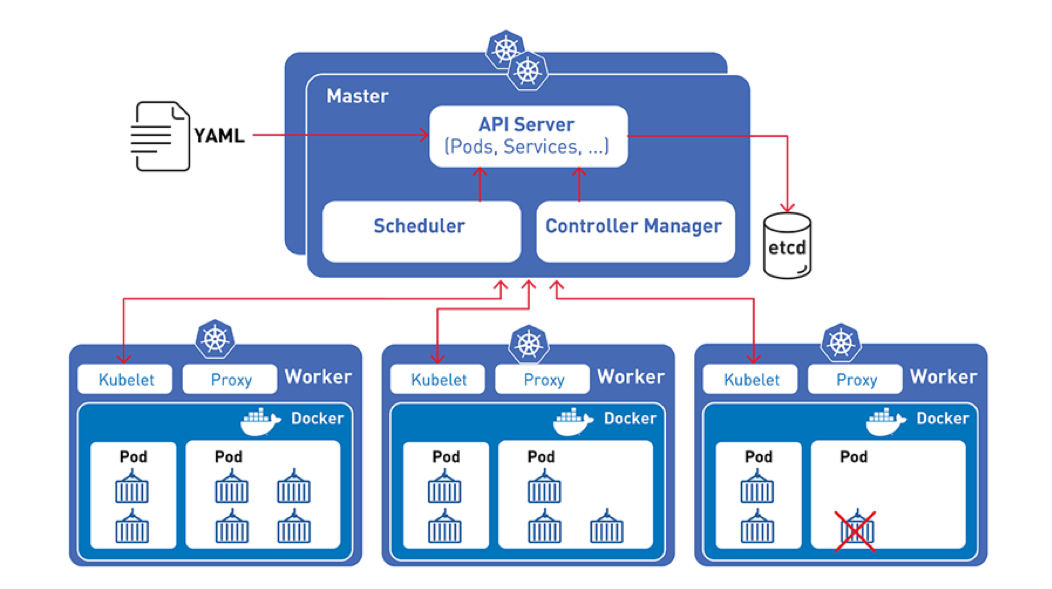

Docker (et un peu LXC)

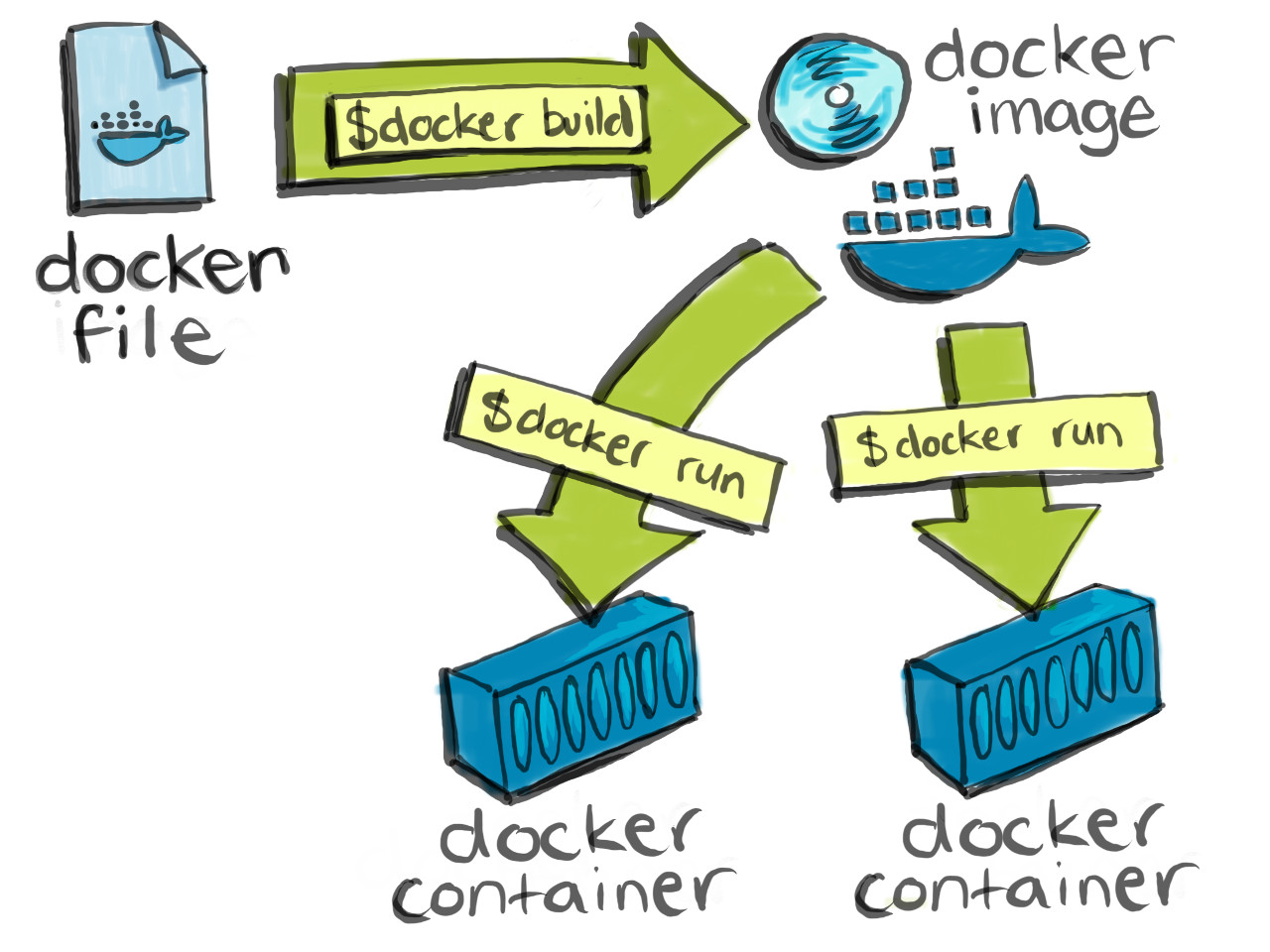

Il s’agit de mettre en quelques sortes les logiciels dans des boîtes :

Avec tout ce qu’il faut pour qu’ils fonctionnent (leurs dépendances).

Ces boîtes sont fermées (on peut ne peux plus les modifier). On parle d'immutabilité.

Si on a besoin d’un nouvelle version on fait un nouveau modèle de boîte. (on dit une nouvelle image docker)

Cette nouvelle image permet de créer autant d’instances que nécessaire.

L’isolation des containers permet d’éviter que les logiciels s’emmêlent entre eux. (Les dépendances ne rentrent pas en conflit)

Les conteneurs non modifiables permettent de savoir exactement l’état de ce qu’on exécute sur l’ordinateur

Le risque de bug diminue énormément : fiabilisation

Les supports de présentation et les TD sont disponibles à l’adresse https://cours.hadrienpelissier.fr

Pour exporter les TD utilisez la fonction d’impression pdf de google chrome.

⚠️ Pour l’anglais, si un texte ne vous paraît pas clair, quelques liens :

Les TP sont réalisables dans une VM disponible depuis votre navigateur, en allant sur https://lab.hadrienpelissier.fr

Se connecter avec votreprenom (en minuscules) et le mot de passe donné.

Puis cliquez sur la machine vnc-votreprenom (si besoin, le mot de passe dans la VM est le même que celui pour accéder au lab)

Ouvrez un autre onglet et cliquez aussi sur la machine appelée vnc-formateur-...

Pour faire un copier-coller depuis l’extérieur à votre VM, il faut appuyer sur les touches Ctrl+Alt+Maj, puis coller ce que l’on veut dans le presse-papier, et refermer la sidebar avec Ctrl+Alt+Maj.

snap install code --classicapt) installez git, htop, ncduDécouvrir le couteau suisse de l’automatisation et de l’infrastructure as code.

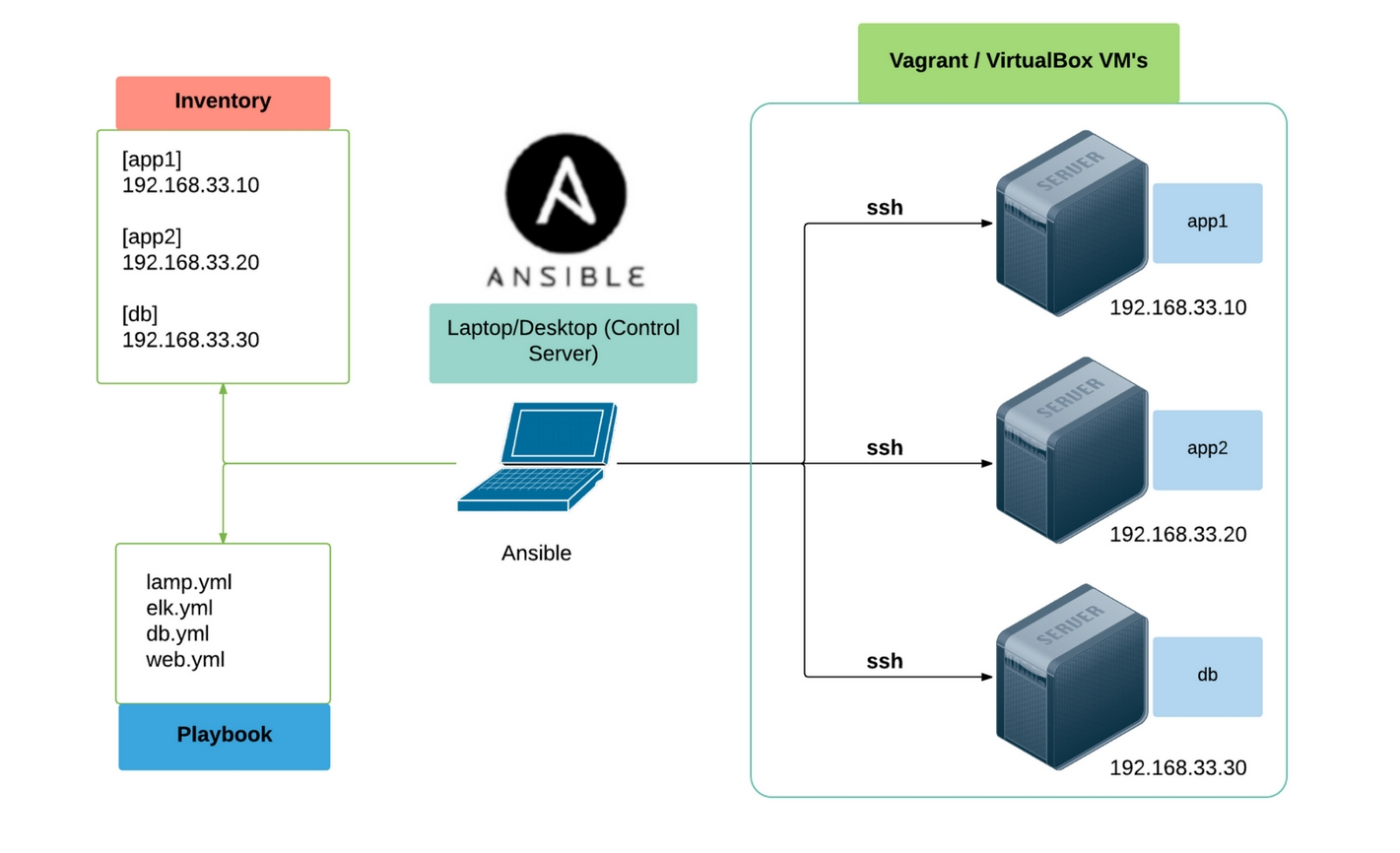

ansible et ses optionsAnsible est un gestionnaire de configuration et un outil de déploiement et d’orchestration très populaire et central dans le monde de l'infrastructure as code (IaC).

Il fait donc également partie de façon centrale du mouvement DevOps car il s’apparente à un véritable couteau suisse de l’automatisation des infrastructures.

Ansible a été créé en 2012 (plus récent que ses concurrents Puppet et Chef) autour d’une recherche de simplicité et du principe de configuration agentless.

Très orienté linux/opensource et versatile il obtient rapidement un franc succès et s’avère être un couteau suisse très adapté à l’automatisation DevOps et Cloud dans des environnements hétérogènes.

Red Hat rachète Ansible en 2015 et développe un certain nombre de produits autour (Ansible Tower, Ansible container avec Openshift).

Ansible est agentless c’est à dire qu’il ne nécessite aucun service/daemon spécifique sur les machines à configurer.

La simplicité d’Ansible provient également du fait qu’il s’appuie sur des technologies linux omniprésentes et devenues universelles.

De fait Ansible fonctionne efficacement sur toutes les distributions linux, debian, centos, ubuntu en particulier (et maintenant également sur Windows).

Ansible est semi-déclaratif c’est à dire qu’il s’exécute séquentiellement mais idéalement de façon idempotente.

Il permet d’avoir un état descriptif de la configuration:

Peut être utilisé pour des opérations ponctuelles comme le déploiement:

Les cas d’usages d’Ansible vont de …:

petit:

moyen:

grand:

Ansible est très complémentaire à docker:

docker_container.Plus récemment avec l’arrivé d'Ansible container il est possible de construire et déployer des conteneurs docker avec du code ansible. Cette solution fait partie de la stack Red Hat Openshift. Concrêtement le langage ansible remplace (avantageusement ?) le langage Dockerfile pour la construction des images Docker.

Pour l’installation plusieurs options sont possibles:

sudo apt-add-repository --yes --update ppa:ansible/ansiblepip le gestionnaire de paquet du langage python: sudo pip3 install

sudo pip3 install ansible --upgradePour voir l’ensemble des fichier installé par un paquet pip3 :

pip3 show -f ansible | less

Pour tester la connexion aux serveurs on utilise la commande ad hoc suivante. ansible all -m ping

Il s’agit d’une liste de machines sur lesquelles vont s’exécuter les modules Ansible. Les machines de cette liste sont:

Exemple :

[all:vars]

ansible_ssh_user=elie

ansible_python_interpreter=/usr/bin/python3

[awx_nodes]

awxnode1 node_state=started ansible_host=10.164.210.101 container_image=centos_ansible_20190901

[dbservers]

pgnode1 node_state=started ansible_host=10.164.210.111 container_image=centos_ansible_20190901

pgnode2 node_state=started ansible_host=10.164.210.112 container_image=centos_ansible_20190901

[appservers]

appnode1 node_state=started ansible_host=10.164.210.121 container_image=centos_ansible_20190901

appnode2 node_state=started ansible_host=10.164.210.122 container_image=centos_ansible_20190901

Les inventaires peuvent également être au format YAML (plus lisible mais pas toujours intuitif) ou JSON (pour les machines).

Ansible se configure classiquement au niveau global dans le dossier /etc/ansible/ dans lequel on retrouve en autre l’inventaire par défaut et des paramètre de configuration.

Ansible est très fortement configurable pour s’adapter à des environnement contraints. Liste des paramètre de configuration:

Alternativement on peut configurer ansible par projet avec un fichier ansible.cfg présent à la racine. Toute commande ansible lancée à la racine du projet récupère automatiquement cette configuration.

ansibleversion minimale :

ansible <groupe_machine> -m <module> -a <arguments_module>

ansible all -m ping: Permet de tester si les hotes sont joignables et ansible utilisable (SSH et python sont présents et configurés).

version plus complète :

ansible <groupe_machine> --inventory <fichier_inventaire> --become -m <module> -a <arguments_module>

Ansible fonctionne grâce à des modules python téléversés sur sur l’hôte à configurer puis exécutés. Ces modules sont conçus pour être cohérents et versatiles et rendre les tâches courantes d’administration plus simples.

Il en existe pour un peu toute les tâches raisonnablement courantes : un slogan Ansible “Batteries included” ! Plus de 1300 modules sont intégrés par défaut.

ping: un module de test Ansible (pas seulement réseau comme la commande ping)

yum/apt: pour gérer les paquets sur les distributions basées respectivement sur Red Hat ou Debian.

... -m yum -a "name=openssh-server state=present"

systemd (ou plus générique service): gérer les services/daemons d’un système.... -m systemd -a "name=openssh-server state=started"

user: créer des utilisateurs et gérer leurs options/permission/groupes

file: pour créer, supprimer, modifier, changer les permission de fichiers, dossier et liens.

shell: pour exécuter des commandes unix grace à un shell

La documentation des modules Ansible se trouve à l’adresse https://docs.ansible.com/ansible/latest/modules/file_module.html

Chaque module propose de nombreux arguments pour personnaliser son comportement:

exemple: le module file permet de gérer de nombreuses opérations avec un seul module en variant les arguments.

Il est également à noter que la plupart des arguments sont facultatifs.

Exemple et bonne pratique: toujours préciser state: present même si cette valeur est presque toujours le défaut implicite.

Pour rappel, les avantages du code Ansible, qui donne tout son intérêt à l’Infrastructure-as-Code sont :

La dimension incrémentale du code rend en particulier plus aisé de construire une infrastructure progressivement en la complexifiant au fur et à mesure plutôt que de devoir tout plannifier à l’avance.

Le playbook est une sorte de script Ansible, c’est-à-dire du code.

Le nom provient du football américain : il s’agit d’un ensemble de stratégies qu’une équipe a travaillé pour répondre aux situations du match. Elle insiste sur la versatilité de l’outil.

Les playbooks ansible sont écrits au format YAML.

A quoi ça ressemble ?

- 1

- Poire

- "Message à caractère informatif"

clé1: valeur1

clé2: valeur2

clé3: 3

marché: # début du dictionnaire global "marché"

lieu: Crimée Curial

jour: dimanche

horaire:

unité: "heure"

min: 9

max: 14 # entier

fruits: # liste de dictionnaires décrivant chaque fruit

- nom: pomme

couleur: "verte"

pesticide: avec # les chaines sont avec ou sans " ou '

- nom: poires

couleur: jaune

pesticide: sans

légumes: # liste de 3 éléments

- courgettes

- salade

# on peut sauter des lignes sans interrompre la liste ou le dictionnaire en cours

- potiron

# fin du dictionnaire global

Pour mieux visualiser l’imbrication des dictionnaires et des listes en YAML on peut utiliser un convertisseur YAML -> JSON : https://www.json2yaml.com/.

Notre marché devient:

{

"marché": {

"lieu": "Crimée Curial",

"jour": "dimanche",

"horaire": {

"unité": "heure",

"min": 9,

"max": 14

},

"fruits": [

{

"nom": "pomme",

"couleur": "verte",

"pesticide": "avec"

},

{

"nom": "poires",

"couleur": "jaune",

"pesticide": "sans"

}

],

"légumes": [

"courgettes",

"salade",

"potiron"

]

}

}

Observez en particulier la syntaxe assez condensée de la liste “fruits” en YAML qui est une liste de dictionnaires.

---

- name: premier play # une liste de play (chaque play commence par un tiret)

hosts: serveur_web # un premier play

become: yes

gather_facts: false # récupérer le dictionnaires d'informations (facts) relatives aux machines

vars:

logfile_name: "auth.log"

var_files:

- mesvariables.yml

pre_tasks:

- name: dynamic variable

set_fact:

mavariable: "{{ inventory_hostname + 'prod' }}" #guillemets obligatoires

rôles:

- flaskapp

tasks:

- name: installer le serveur nginx

apt: name=nginx state=present # syntaxe concise proche des commandes ad hoc mais moins lisible

- name: créer un fichier de log

file: # syntaxe yaml extensive : conseillée

path: /var/log/{{ logfile_name }} #guillemets facultatifs

mode: 755

- import_tasks: mestaches.yml

handlers:

- systemd:

name: nginx

state: "reloaded"

- name: un autre play

hosts: dbservers

tasks:

...

Un playbook commence par un tiret car il s’agit d’une liste de plays.

Un play est un dictionnaire yaml qui décrit un ensemble de tâches ordonnées en plusieurs sections. Un play commence par préciser sur quelles machines il s’applique puis précise quelques paramètres faculatifs d’exécution comme become: yes pour l’élévation de privilège (section hosts).

La section hosts est obligatoire. Toutes les autres sections sont facultatives !

La section tasks est généralement la section principale car elle décrit les tâches de configuration à appliquer.

La section tasks peut être remplacée ou complétée par une section roles et des sections pre_tasks post_tasks

Les handlers sont des tâches conditionnelles qui s’exécutent à la fin (post traitements conditionnels comme le redémarrage d’un service)

pre_tasksrolestaskspost_taskshandlersLes rôles ne sont pas des tâches à proprement parler mais un ensemble de tâches et ressources regroupées dans un module, un peu comme une librairie dans le développement. Nous explorerons les rôles au cours 3.

name: qui décrit lors de l’exécution la tâche en cours : un des principes de l’Infrastructure-as-Code est l’intelligibilité des opérations.Pour valider la syntaxe il est possible d’installer et utiliser ansible-linter sur les fichiers YAML.

L’élévation de privilège est nécessaire lorsqu’on a besoin d’être root pour exécuter une commande ou plus généralement qu’on a besoin d’exécuter une commande avec un utilisateur différent de celui utilisé pour la connexion on peut utiliser:

Au moment de l’exécution l’argument --become en ligne de commande avec ansible, ansible-console ou ansible-playbook.

La section become: yes

hosts) : toutes les tâches seront executée avec cette élévation par défaut.Pour executer une tâche avec un autre utilisateur que root (become simple) ou celui de connexion (sans become) on le précise en ajoutant à become: yes, become_user: username

Ansible utilise en arrière plan un dictionnaire contenant de nombreuses variables.

Pour s’en rendre compte on peut lancer :

ansible <hote_ou_groupe> -m debug -a "msg={{ hostvars }}"

Ce dictionnaire contient en particulier:

ansible_user par exemple)ansible_os_family) et récupéré au lancement d’un playbook.La plupart des fichiers Ansible (sauf l’inventaire) sont traités avec le moteur de template python JinJa2.

Ce moteur permet de créer des valeurs dynamiques dans le code des playbooks, des rôles, et des fichiers de configuration.

Les variables écrites au format {{ mavariable }} sont remplacées par leur valeur provenant du dictionnaire d’exécution d’Ansible.

Des filtres (fonctions de transformation) permettent de transformer la valeur des variables: exemple : {{ hostname | default('localhost') }} (Voir plus bas)

Les fichiers de templates (.j2) utilisés avec le module template, généralement pour créer des fichiers de configuration peuvent contenir des variables et des filtres comme les fichier de code (voir au dessus) mais également d’autres constructions jinja2 comme:

if : {% if nginx_state == 'present' %}...{% endif %}.for : {% for host in groups['appserver'] %}...{% endfor %}.{% include 'autre_fichier_template.j2' %}On peut définir et modifier la valeur des variables à différents endroits du code ansible:

vars: du playbook.var_files:group_vars, host_barsdefaults des rôles (cf partie sur les rôles)set_facts.--extra-vars "version=1.23.45 other_variable=foo"Lorsque définies plusieurs fois, les variables ont des priorités en fonction de l’endroit de définition.

L’ordre de priorité est plutôt complexe: https://docs.ansible.com/ansible/latest/user_guide/playbooks_variables.html#variable-precedence-where-should-i-put-a-variable

En résumé la règle peut être exprimée comme suit: les variables de runtime sont prioritaires sur les variables dans un playbook qui sont prioritaires sur les variables de l’inventaire qui sont prioritaires sur les variables par défaut d’un rôle.

groups.all et groups['all'] sont deux syntaxes équivalentes pour désigner les éléments d’un dictionnaire.https://docs.ansible.com/ansible/latest/reference_appendices/special_variables.html

Les plus utiles:

hostvars: dictionaire de toute les variables rangées par hote de l’inventaire.ansible_host: information utilisée pour la connexion (ip ou domaine).inventory_hostname: nom de la machine dans l’inventaire.groups: dictionnaire de tous les groupes avec la liste des machines appartenant à chaque groupe.Pour explorer chacune de ces variables vous pouvez utiliser le module debug en mode adhoc ou dans un playbook:

ansible <hote_ou_groupe> -m debug -a "msg={{ ansible_host }}"

ou encore:

ansible <hote_ou_groupe> -m debug -a "msg={{ groups.all }}"

Les facts sont des valeurs de variables récupérées au début de l’exécution durant l’étape gather_facts et qui décrivent l’état courant de chaque machine.

ansible_os_family est un fact/variable décrivant le type d’OS installé sur la machine. Elle n’existe qu’une fois les facts récupérés.! Lors d’une commande adhoc ansible les facts ne sont pas récupérés : la variable ansible_os_family ne sera pas disponible.

La liste des facts peut être trouvée dans la documentation et dépend des plugins utilisés pour les récupérés: https://docs.ansible.com/ansible/latest/user_guide/playbooks_vars_facts.html

whenElle permet de rendre une tâche conditionnelle (une sorte de if)

- name: start nginx service

systemd:

name: nginx

state: started

when: ansible_os_family == 'RedHat'

Sinon la tâche est sautée (skipped) durant l’exécution.

loop:Cette directive permet d’executer une tâche plusieurs fois basée sur une liste de valeur:

https://docs.ansible.com/ansible/latest/user_guide/playbooks_loops.html

exemple:

- hosts: localhost

tasks:

- name: exemple de boucle

debug:

msg: "{{ item }}"

loop:

- message1

- message2

- message3

On peut également controler cette boucle avec quelques paramètres:

- hosts: localhost

vars:

messages:

- message1

- message2

- message3

tasks:

- name: exemple de boucle

debug:

msg: "message numero {{ num }} : {{ message }}"

loop: "{{ messages }}"

loop_control:

loop_var: message

index_var: num

Cette fonctionnalité de boucle était anciennement accessible avec le mot clé with_items: qui est maintenant déprécié.

Pour transformer la valeur des variables à la volée lors de leur appel on peut utiliser des filtres (jinja2) :

{{ hostname | default('localhost') }}La liste complète des filtres ansible se trouve ici : https://docs.ansible.com/ansible/latest/user_guide/playbooks_filters.html

Avec Ansible on dispose d’au moins trois manières de debugger un playbook:

Rendre la sortie verbeuse (mode debug) avec -vvv.

Utiliser une tâche avec le module debug : debug msg="{{ mavariable }}".

Utiliser la directive debugger: always ou on_failed à ajouter à la fin d’une tâche. L’exécution s’arrête alors après l’exécution de cette tâche et propose un interpreteur de debug.

Les commandes et l’usage du debugger sont décrits dans la documentation: https://docs.ansible.com/ansible/latest/user_guide/playbooks_debugger.html

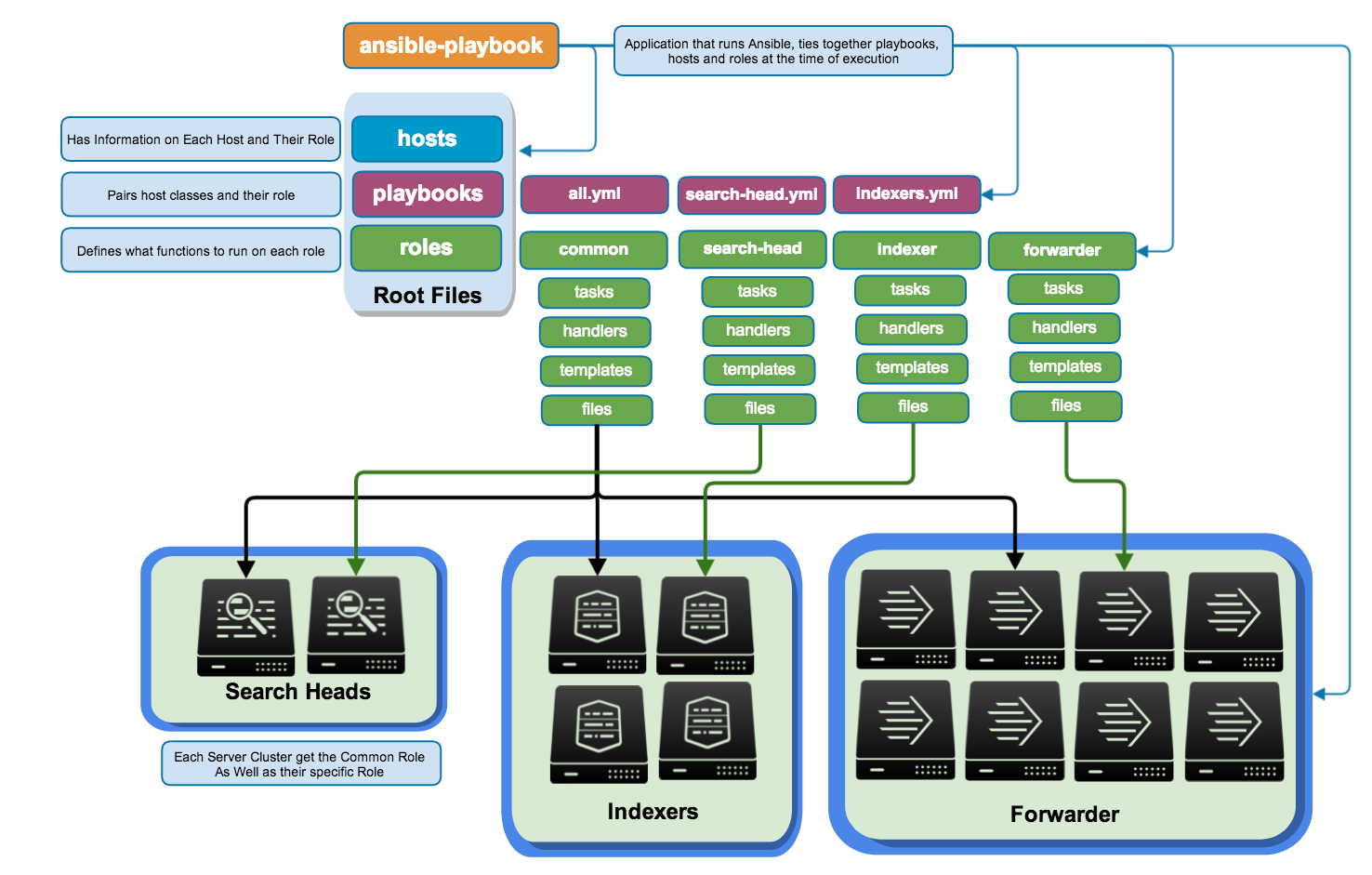

Voici, extrait de la documentation Ansible sur les “Best Practice”, l’une des organisations de référence d’un projet ansible de configuration d’une infrastructure:

production # inventory file for production servers

staging # inventory file for staging environment

group_vars/

group1.yml # here we assign variables to particular groups

group2.yml

host_vars/

hostname1.yml # here we assign variables to particular systems

hostname2.yml

site.yml # master playbook

webservers.yml # playbook for webserver tier

dbservers.yml # playbook for dbserver tier

roles/

common/ # this hierarchy represents a "role"

... # role code

webtier/ # same kind of structure as "common" was above, done for the webtier role

monitoring/ # ""

fooapp/ # ""

Plusieurs remarques:

--inventory production.group_vars et host_vars. On met à l’intérieur un fichier <nom_du_groupe>.yml qui contient un dictionnaire de variables.playbooks ou operations pour certaines opérations ponctuelles. (cf cours 4)library du projet ou d’un rôle et on le précise éventuellement dans ansible.cfg.common : il est utilisé ici pour rassembler les tâches de base et communes à toutes les machines. Par exemple s’assurer que les clés ssh de l’équipe sont présentes, que les dépôts spécifiques sont présents, etc.

Découper les tâches de configuration en sous-ensembles réutilisables (une suite d’étapes de configuration).

Ansible est une sorte de langage de programmation et l’intérêt du code est de pouvoir créer des fonctions regroupées en librairies et les composer. Les rôles sont les “librairies” Ansible en quelque sorte.

Comme une fonction, un rôle prend généralement des paramètres qui permettent de personnaliser son comportement.

Tout le nécessaire doit y être (fichiers de configurations, archives et binaires à déployer, modules personnels dans library etc.)

Remarque : ne pas confondre modules et roles. file est un module, geerlingguy.docker est un rôle. On doit écrire des rôles pour coder correctement en Ansible, on peut écrire des modules mais c’est largement facultatif car la plupart des actions existent déjà.

Présentation d’un exemple de rôle : https://github.com/geerlingguy/ansible-role-docker

docker_edition.README pour en décrire l’usage et un fichier meta/main.yml qui décrit la compatibilité et les dépendances, en plus de la licence et l’auteur.ansible-galaxy.Un rôle est un dossier avec des sous-dossiers conventionnels:

roles/

my_role/ # hiérarchie du rôle "my_role"

tasks/ #

main.yml # <-- le fichier de tâches exécuté par défaut

handlers/ #

main.yml # <-- les handlers

templates/ # <-- dossier des templates

ntp.conf.j2 # <------- les templates finissent par .j2

files/ #

foo.sh # <-- d'autres fichiers si nécessaire

vars/ #

main.yml # <-- variables internes du rôle

defaults/ #

main.yml # <-- variables par défaut pour le rôle

meta/ #

main.yml # <-- informations sur le rôle

On constate que les noms des sous-dossiers correspondent souvent à des sections du playbook. En fait le principe de base est d’extraire les différentes listes de tâches ou de variables dans des sous-dossiers.

Remarque : les fichiers de liste doivent nécessairement s’appeler main.yml" (pas très intuitif)

Remarque 2 : main.yml peut en revanche importer d’autres fichiers aux noms personnalisés (ex: rôle docker de geerlingguy)

Le dossier defaults contient les valeurs par défaut des paramètres du rôle. Ces valeurs ne sont jamais prioritaires (elles sont écrasées par n’importe quelle autre définition de la même variable ailleurs dans le code Ansible)

Le fichier meta/main.yml est facultatif mais conseillé et contient des informations sur le rôle

Le dossier files contient les fichiers qui ne sont pas des templates (pour les module copy ou sync, script etc).

C’est le store de rôles officiel d’Ansible : https://galaxy.ansible.com/

C’est également le nom d’une commande ansible-galaxy qui permet d’installer des rôles et leurs dépendances depuis internet. Un sorte de gestionnaire de paquets pour Ansible.

Elle est utilisée généralement sour la forme ansible install -r roles/requirements.yml -p roles <nom_role>, ou plus simplement ansible-galaxy install <role> (mais installe dans /etc/ansible/roles dans ce cas).

Tous les rôles Ansible sont communautaires (pas de rôles officiels) et généralement stockés sur Github ou Gitlab.

Mais on peut voir la popularité (étoiles Github), et la présence de tests (avec un outil Ansible appelé Molecule), qui garantissement la plus ou moins grande fiabilité et qualité du rôle.

Il existe des rôles pour installer un peu n’importe quelle application serveur courante aujourd’hui. Passez du temps à explorer le web avant de développer quelque chose avec Ansible.

requirements.ymlConventionnellement on utilise un fichier requirements.yml situé dans roles pour décrire la liste des rôles nécessaires à un projet.

- src: geerlingguy.repo-epel

- src: geerlingguy.haproxy

- src: geerlingguy.docke

# from GitHub, overriding the name and specifying a specific tag

- src: https://github.com/bennojoy/nginx

version: master

name: nginx_role

ansible-galaxy install -r roles/requirements.yml -p roles.Il est possible d’importer le contenu d’autres fichiers dans un playbook:

import_tasks: importe une liste de tâches (atomiques)import_playbook: importe une liste de play contenus dans un playbook.Les deux instructions précédentes désignent un import statique qui est résolu avant l’exécution.

Au contraire, include_tasks permet d’intégrer une liste de tâche dynamiquement pendant l’exécution.

Par exemple :

vars:

apps:

- app1

- app2

- app3

tasks:

- include_tasks: install_app.yml

loop: "{{ apps }}"

Ce code indique à Ansible d’exécuter une série de tâches pour chaque application de la liste. On pourrait remplacer cette liste par une liste dynamique. Comme le nombre d’imports ne peut pas facilement être connu à l’avance on doit utiliser include_tasks.

Savoir si on doit utiliser include ou import se fait selon les cas et avec tâtonnement le plus souvent.

Les problématiques de sécurité Linux ne sont pas du tout résolues magiquement par Ansible. Tous le travail de réflexion et de sécurisation reste identique mais peut, comme le reste, être mieux controllé grâce à l’approche déclarative de l’infrastructure as code.

Si cette problématique des liens entre Ansible et sécurité vous intéresse, il existe un livre appelé Security automation with Ansible.

Il est à noter tout de même qu’Ansible est généralement apprécié d’un point de vue sécurité car il n’augmente pas (vraiment) la surface d’attaque de vos infrastructures : il est basé sur ssh qui est éprouvé et ne nécessite généralement pas de réorganisation des infrastructures.

Pour les cas plus spécifiques, Ansible est relativement agnostique du mode de connexion grâce aux plugins de connexions (voir ci-dessous).

Un bonne pratique : changer le port de connexion ssh pour un port atypique. Vous pourrez ajouter la variable ansible_ssh_port=17728 dans l’inventaire.

Il faut idéalement éviter de créer un seul compte Ansible de connexion pour toutes les machines :

Il faut utiliser comme nous avons fait dans les TP des logins ssh avec des utilisateurs aux noms correspondant aux usages ou aux humains derrière, et des clés ssh. C’est-à-dire le même modèle d’authentification que l’administration traditionnelle.

Le mode de connexion par défaut de Ansible est SSH, cependant il est possible d’utiliser de nombreux autres modes de connexion spécifiques :

Pour afficher la liste des plugins disponible lancez ansible-doc -t connection -l.

Une autre connexion courante est ansible_connection=local qui permet de configurer la machine locale sans avoir besoin d’installer un serveur ssh.

Citons également les connexions ansible_connexion=docker et ansible_connexion=lxd pour configurer des conteneurs linux ainsi que ansible_connexion=winrm pour les serveurs windows

Les questions de sécurités de la connexion se posent bien sûr différemment selon le mode de connexion utilisé (port, authentification, etc.)

Pour débugger les connexions et diagnotiquer leur sécurité on peut afficher les détails de chaque connexion ansible avec le mode de verbosité maximal en utilisant le paramètre -vvvv.

Le principal risque de sécurité lié à Ansible comme avec Docker et l’infrastructure-as-code en général consiste à laisser trainer des secrets (mot de passe, identités de clients, tokens d’API, secrets de chiffrement / migration etc.) dans le code (ou sur les serveurs à des endroits non prévus).

Attention : les dépôts git peuvent cacher des secrets dans leur historique. Pour nettoyer un secret dans un dépôt Git, l’outil le plus courant est BFG : https://rtyley.github.io/bfg-repo-cleaner/

Ansible propose une directive no_log: yes qui permet de désactiver l’affichage des valeurs d’entrée et de sortie d’une tâche.

Il est ainsi possible de limiter la prolifération de données sensibles.

Par exemple, si une tâche change une entrée en base qui contient un mot de passe, no_log: yes est tout indiqué.

Pour éviter de divulguer des secrets par inadvertance, il est possible de gérer les secrets avec des variables d’environnement ou avec un fichier variable externe au projet qui échappera au versionning git, mais ce n’est pas idéal.

Ansible intègre un trousseau de secrets appelé Ansible Vault. Il permet de chiffrer des valeurs variables par variables ou via des fichiers complets. Les valeurs stockées dans le trousseau sont déchiffrées à l’exécution après déverrouillage du trousseau.

ansible-vault create /var/secrets.ymlansible-vault edit /var/secrets.yml ouvre $EDITOR pour changer le fichier de variables.ansible-vault encrypt_file /vars/secrets.yml pour chiffrer un fichier existantansible-vault encrypt_string monmotdepasse permet de chiffrer une valeur avec un mot de passe. le résultat peut être ensuite collé dans un fichier de variables par ailleurs en clair.Pour déchiffrer il est ensuite nécessaire d’ajouter l’option --ask-vault-pass au moment de l’exécution de ansible ou ansible-playbook

Il existe également un mode pour gérer plusieurs mots de passe associés à des identifiants.

L’automatisation Ansible fait d’autant plus sens dans un environnement dynamique d’infrastructures :

Il existe de nombreuses solutions pour intégrer Ansible avec les principaux providers de cloud (modules Ansible, plugins d’API, intégration avec d’autre outils d’Infrastructure-as-Code cloud comme Terraform ou Cloudformation).

Les inventaires que nous avons utilisés jusqu’ici implique d’affecter à la main les adresses IP des différents noeuds de notre infrastructure. Cela devient vite ingérable si celle-ci change souvent.

La solution Ansible pour ne pas gérer les IP et les groupes à la main est appelée inventaire dynamique ou inventory plugin. Un inventaire dynamique est simplement un programme qui renvoie un JSON respectant le format d’inventaire JSON Ansible, généralement en contactant l’API du cloud provider ou une autre source.

$ ./inventory_terraform.py

{

"_meta": {

"hostvars": {

"balancer0": {

"ansible_host": "104.248.194.100"

},

"balancer1": {

"ansible_host": "104.248.204.222"

},

"awx0": {

"ansible_host": "104.248.204.202"

},

"appserver0": {

"ansible_host": "104.248.202.47"

}

}

},

"all": {

"children": [],

"hosts": [

"appserver0",

"awx0",

"balancer0",

"balancer1"

],

"vars": {}

},

"appservers": {

"children": [],

"hosts": [

"balancer0",

"balancer1"

],

"vars": {}

},

"awxnodes": {

"children": [],

"hosts": [

"awx0"

],

"vars": {}

},

"balancers": {

"children": [],

"hosts": [

"appserver0"

],

"vars": {}

}

}%

On peut ensuite appeler ansible-playbook en utilisant ce programme plutôt qu’un fichier statique d’inventaire: ansible-playbook -i inventory_terraform.py configuration.yml

Bonne pratique : Normalement l’information de configuration Ansible doit provenir au maximum de l’inventaire. Ceci est conforme à l’orientation plutôt déclarative d’Ansible et à son exécution descendante (master -> nodes). La méthode à privilégier pour intégrer Ansible à des sources d’information existantes est donc d’utiliser ou développer un plugin d’inventaire.

https://docs.ansible.com/ansible/latest/plugins/inventory.html

On peut cependant alimenter le dictionnaire de variable Ansible au fur et à mesure de l’exécution, en particulier grâce à la directive register et au module set_fact.

Exemple:

# this is just to avoid a call to |default on each iteration

- set_fact:

postconf_d: {}

- name: 'get postfix default configuration'

command: 'postconf -d'

register: postconf_result

changed_when: false

# the answer of the command give a list of lines such as:

# "key = value" or "key =" when the value is null

- name: 'set postfix default configuration as fact'

set_fact:

postconf_d: >

{{ postconf_d | combine(dict([ item.partition('=')[::2]map'trim') ])) }}

loop: postconf_result.stdout_lines

On peut explorer plus facilement la hiérarchie d’un inventaire statique ou dynamique avec la commande:

ansible-inventory --inventory <inventory> --graph

https://docs.ansible.com/ansible/latest/dev_guide/developing_plugins.html

Pour les VPS de base Amazon EC2 : utiliser un plugin d’inventaire AWS et les modules adaptés.

Possibilité 1 : Gérer l’exécution de tâches Ansible et le monitoring Nagios séparément, utiliser le module nagios pour désactiver les alertes Nagios lorsqu’on manipule les ressources monitorées par Nagios.

Possibilité 2 : Laisser le contrôle à Nagios et utiliser un plugin pour que Nagios puisse lancer des plays Ansible en réponse à des évènements sur les sondes.

apt en lançant:$ sudo apt update

$ sudo apt install software-properties-common

$ sudo apt-add-repository --yes --update ppa:ansible/ansible

$ sudo apt install ansible

ansible --version

=> 2.8.x

ansible all -m ping. Que signifie-t-elle ?-vvv pour mettre en mode très verbeux. Ce mode est très efficace pour debugger lorsqu’une erreur inconnue se présente. Que se passe-t-il avec l’inventaire ?ansible en vous connectant à votre machine localhost et en utilisant le module ping.hotelocal ansible_host=127.0.0.1 dans l’inventaire par défaut (le chemin est /etc/ansible/hosts). Et pinguer hotelocal.LXD est une technologie de conteneurs actuellement promue par canonical (ubuntu) qui permet de faire des conteneur linux orientés systèmes plutôt qu’application. Par exemple systemd est disponible à l’intérieur des conteneurs contrairement aux conteneurs Docker.

LXD est déjà installé et initialisé sur notre ubuntu (sinon apt install snapd + snap install lxd + ajouter votre utilisateur courant au group unix lxd).

Il faut cependant l’initialiser avec : lxd init

Cette commande vous pose un certain nombre de questions pour la configuration et vous pouvez garder TOUTES les valeurs par défaut en fait ENTER simplement à chaque question.

Affichez la liste des conteneurs avec lxc list. Aucun conteneur ne tourne.

Maintenant lançons notre premier conteneur centos avec lxc launch images:centos/7/amd64 centos1.

Listez à nouveau les conteneurs lxc.

Ce conteneur est un centos minimal et n’a donc pas de serveur SSH pour se connecter. Pour lancez des commandes dans le conteneur on utilise une commande LXC pour s’y connecter lxc exec <non_conteneur> -- <commande>. Dans notre cas nous voulons lancer bash pour ouvrir un shell dans le conteneur : lxc exec centos1 -- bash.

Nous pouvons installer des logiciels dans le conteneur comme dans une VM. Pour sortir du conteneur on peut simplement utiliser exit.

Un peu comme avec Docker, LXC utilise des images modèles pour créer des conteneurs. Affichez la liste des images avec lxc image list. Trois images sont disponibles l’image centos vide téléchargée et utilisée pour créer centos1 et deux autres images préconfigurée ubuntu_ansible et centos_ansible. Ces images contiennent déjà la configuration nécessaire pour être utilisée avec ansible (SSH + Python + Un utilisateur + une clé SSH).

Supprimez la machine centos1 avec lxc stop centos1 && lxc delete centos1

Pour avoir tous les mêmes images de base générons-les depuis un script pré-installé, dans un terminal lancez :

bash /opt/lxd.sh

Créons à partir des images du remotes un conteneur ubuntu et un autre centos:

lxc launch ubuntu_ansible ubu1

lxc launch centos_ansible centos1

Pour se connecter en SSH nous allons donc utiliser une clé SSH appelée id_stagiaire qui devrait être présente dans votre dossier ~/.ssh/. Vérifiez cela en lançant ls -l /home/stagiaire/.ssh.

Déverrouillez cette clé ssh avec ssh-add ~/.ssh/id_stagiaire et le mot de passe devops101 (le ssh-agent doit être démarré dans le shell pour que cette commande fonctionne si ce n’est pas le cas eval $(ssh-agent)).

Essayez de vous connecter à ubu1 et centos1 en ssh pour vérifier que la clé ssh est bien configurée et vérifiez dans chaque machine que le sudo est configuré sans mot de passe avec sudo -i.

Lorsqu’on développe avec Ansible il est conseillé de le gérer comme un véritable projet de code :

inventory.cfg ou hosts et une configuration locale au projet ansible.cfgNous allons créer un tel projet de code pour la suite du tp1

tp1 sur le Bureau.Open Folder...Un projet Ansible implique généralement une configuration Ansible spécifique décrite dans un fichier ansible.cfg

ansible.cfg avec à l’intérieur:[defaults]

inventory = ./inventory.cfg

roles_path = ./roles

host_key_checking = false # nécessaire pour les labs où l'on créé et supprime des machines constamment avec des signatures SSH changées.

ansible.cfg et ajoutez à l’intérieur notre nouvelle machine hote1.Créez et complétez le fichier inventory.cfg d’après ce modèle:

ubu1 ansible_host=<ip>

[all:vars]

ansible_user=<votre_user>

Ansible cherche la configuration locale dans le dossier courant. Conséquence : on lance généralement toutes les commandes Ansible depuis la racine de notre projet.

Dans le dossier du projet, essayez de relancer la commande ad-hoc ping sur cette machine.

Ansible implique le cas échéant (login avec clé ssh) de déverrouiller la clé ssh pour se connecter à chaque hôte. Lorsqu’on en a plusieurs il est donc nécessaire de la déverrouiller en amont avec l’agent ssh pour ne pas perturber l’exécution des commandes ansible. Pour cela : ssh-add.

Créez un groupe adhoc_lab et ajoutez les deux machines ubu1 et centos1.

ping sur les deux machines.ansible.cfg. Cependant on peut aussi utiliser une connexion par mot de passe et préciser l’utilisateur et le mot de passe dans l’inventaire ou en lançant la commande.En précisant les paramètres de connexion dans le playbook il et aussi possible d’avoir des modes de connexion différents pour chaque machine.

adhoc_lab, centos_hosts et ubuntu_hosts avec deux machines dans chacun. (utilisez pour cela [adhoc_lab:children])[all:vars]

ansible_user=<votre_user>

[ubuntu_hosts]

ubu1 ansible_host=<ip>

[centos_hosts]

centos1 ansible_host=<ip>

[adhoc_lab:children]

ubuntu_hosts

centos_hosts

Dans un inventaire ansible on commence toujours par créer les plus petits sous groupes puis on les rassemble en plus grands groupes.

Nous allons maintenant installer nginx sur les 2 machines. Il y a plusieurs façons d’installer des logiciels grâce à Ansible: en utilisant le gestionnaire de paquets de la distribution ou un gestionnaire spécifique comme pip ou npm. Chaque méthode dispose d’un module ansible spécifique.

apt car centos utilise yum. Pour éviter ce problème on peut utiliser le module package qui permet d’uniformiser l’installation (pour les cas simples).

--become pour devenir root avant d’exécuter la commande (cf élévation de privilège dans le cours2)nginxepel-release sur la machine centos.nginx. Que remarque-t-on ?systemd et l’option --check pour vérifier si le service nginx est démarré sur chacune des 2 machines. Normalement vous constatez que le service est déjà démarré (par défaut) sur la machine ubuntu et non démarré sur la machine centos.L’option --check à vérifier l’état des ressources sur les machines mais sans modifier la configuration`. Relancez la commande précédente pour le vérifier. Normalement le retour de la commande est le même (l’ordre peu varier).

Lancez la commande avec state=stopped : le retour est inversé.

Enlevez le --check pour vous assurer que le service est démarré sur chacune des machines.

Visitez dans un navigateur l’ip d’un des hôtes pour voir la page d’accueil nginx.

Il existe trois façon de lancer des commandes unix avec ansible:

le module command utilise python pour lancez la commande.

le module shell utilise un module python qui appelle un shell pour lancer une commande.

le module raw.

creates pour simuler de l’idempotence.Créez un fichier dans /tmp avec touch et l’un des modules précédents.

Relancez la commande. Le retour est toujours changed car ces modules ne sont pas idempotents.

Relancer l’un des modules shell ou command avec touch et l’option creates pour rendre l’opération idempotente. Ansible détecte alors que le fichier témoin existe et n’exécute pas la commande.

ansible adhoc_lab --become -m "command touch /tmp/file" -a "creates=/tmp/file"

tp2_flask_deployment.ansible.cfg comme précédemment.[defaults]

inventory = ./inventory.cfg

roles_path = ./roles

host_key_checking = false

inventory.cfg.

[all:vars]

ansible_user=<user>

[appservers]

app1 ansible_host=10.x.y.z

app2 ansible_host=10.x.y.z

appservers.ansible all -m ping

Le but de ce projet est de déployer une application flask, c’est a dire une application web python. Le code (très minimal) de cette application se trouve sur github à l’adresse: https://github.com/e-lie/flask_hello_ansible.git.

N’hésitez pas consulter extensivement la documentation des modules avec leur exemple ou d’utiliser la commande de doc ansible-doc <module>

Créons un playbook : ajoutez un fichier flaskhello_deploy.yml avec à l’intérieur:

- hosts: <hotes_cible>

tasks:

- name: ping

ping:

Lancez ce playbook avec la commande ansible-playbook <nom_playbook>.

Commençons par installer les dépendances de cette application. Tous nos serveurs d’application sont sur ubuntu. Nous pouvons donc utiliser le module apt pour installer les dépendances. Il fournit plus d’option que le module package.

Avec le module apt installez les applications: python3-dev, python3-pip, python3-virtualenv, virtualenv, nginx, git. Donnez à cette tâche le nom: ensure basic dependencies are present. Ajoutez, pour devenir root, la directive become: yes au début du playbook.

- name: Ensure apt dependencies are present

apt:

name:

- python3-dev

- python3-pip

- python3-virtualenv

- virtualenv

- nginx

- git

state: present

Lancez ce playbook sans rien appliquer avec la commande ansible-playbook <nom_playbook> --check --diff. La partie --check indique à Ansible de ne faire aucune modification. La partie --diff nous permet d’afficher ce qui changerait à l’application du playbook.

Relancez bien votre playbook à chaque tâche : comme Ansible est idempotent il n’est pas grave en situation de développement d’interrompre l’exécution du playbook et de reprendre l’exécution après un échec.

Ajoutez une tâche systemd pour s’assurer que le service nginx est démarré.

- name: Ensure nginx service started

systemd:

name: nginx

state: started

flask et l’ajouter au groupe www-data. Utilisez bien le paramètre append: yes pour éviter de supprimer des groupes à l’utilisateur. - name: Add the user running webapp

user:

name: "flask"

state: present

append: yes # important pour ne pas supprimer les groupes d'un utilisateur existant

groups:

- "www-data"

Pour déployer le code de l’application deux options sont possibles.

sync qui fait une copie rsync.git.Nous allons utiliser la deuxième option (git) qui est plus cohérente pour le déploiement et la gestion des versions logicielles. Allez voir la documentation comment utiliser ce module.

Utilisez le pour télécharger le code source de l’application (branche master) dans le dossier /home/flask/hello mais en désactivant la mise à jour (au cas ou le code change).

- name: Git clone/update python hello webapp in user home

git:

repo: "https://github.com/e-lie/flask_hello_ansible.git"

dest: /home/flask/hello

version: "master"

clone: yes

update: no

Le langage python a son propre gestionnaire de dépendances pip qui permet d’installer facilement les librairies d’un projet. Il propose également un méchanisme d’isolation des paquets installés appelé virtualenv. Normalement installer les dépendances python nécessite 4 ou 5 commandes shell.

La liste de nos dépendances est listée dans le fichier requirements.txt à la racine du dossier d’application.

Nous voulons installer ces dépendances dans un dossier venv également à la racine de l’application.

Nous voulons installer ces dépendances en version python3 avec l’argument virtualenv_python: python3.

Avec ces informations et la documentation du module pip installez les dépendances de l’application.

Notre application sera executée en tant qu’utilisateur flask pour des raisons de sécurité. Pour cela le dossier doit appartenir à cet utilisateur or il a été créé en tant que root (à cause du become: yes de notre playbook).

file qui change le propriétaire du dossier de façon récursive. - name: Change permissions of app directory

file:

path: /home/flask/hello

state: directory

owner: "flask"

recurse: true

Notre application doit tourner comme c’est souvent le cas en tant que service (systemd). Pour cela nous devons créer un fichier service adapté hello.service dans le le dossier /etc/systemd/system/.

Ce fichier est un fichier de configuration qui doit contenir le texte suivant:

[Unit]

Description=Gunicorn instance to serve hello

After=network.target

[Service]

User=flask

Group=www-data

WorkingDirectory=/home/flask/hello

Environment="PATH=/home/flask/hello/venv/bin"

ExecStart=/home/flask/hello/venv/bin/gunicorn --workers 3 --bind unix:hello.sock -m 007 app:app

[Install]

WantedBy=multi-user.target

Pour gérer les fichier de configuration on utilise généralement le module template qui permet à partir d’un fichier modèle situé dans le projet ansible de créer dynamiquement un fichier de configuration adapté sur la machine distante.

Créez un dossier templates, avec à l’intérieur le fichier app.service.j2 contenant le texte précédent.

Utilisez le module template pour le copier au bon endroit avec le nom hello.service.

Utilisez ensuite systemd pour démarrer ce service (state: restarted ici pour le cas ou le fichier à changé).

hello.test.conf dans le dossier /etc/nginx/sites-available à partir du fichier modèle:nginx.conf.j2

server {

listen 80;

server_name hello.test;

location / {

include proxy_params;

proxy_pass http://unix:/home/flask/hello/hello.sock;

}

}

Utilisez file pour créer un lien symbolique de ce fichier dans /etc/nginx/sites-enabled (avec l’option force:yes pour écraser le cas échéant).

Ajoutez une tâche pour supprimer le site /etc/nginx/sites-enabled/default.

Ajouter une tâche de redémarrage de nginx.

Ajoutez hello.test dans votre fichier /etc/hosts pointant sur l’ip d’un des serveur d’application.

Visitez l’application dans un navigateur et debugger le cas échéant.

flaskhello_deploy.yml

Ajoutons des variables pour gérer dynamiquement les paramètres de notre déploiement:

Ajoutez une section vars: avant la section tasks: du playbook.

Mettez dans cette section la variable suivante (dictionnaire):

app:

name: hello

user: flask

domain: hello.test

Remplacez dans le playbook précédent et les deux fichiers de template:

hello par {{ app.name }}flask par {{ app.user }}hello.test par {{ app.domain }}Relancez le playbook : toutes les tâches devraient renvoyer ok à part les “restart” car les valeurs sont identiques.

tp2_before_handlers_correction avec git checkout tp2_before_handlers_correction.Le dépôt contient également les corrigés du TP3 et TP4 dans d’autre branches.

Vous pouvez consultez la correction également directement sur le site de github.

Pour le moment dans notre playbook, les deux tâches de redémarrage de service sont en mode restarted c’est à dire qu’elles redémarrent le service à chaque exécution (résultat: changed) et ne sont donc pas idempotentes. En imaginant qu’on lance ce playbook toutes les 15 minutes dans un cron pour stabiliser la configuration, on aurait un redémarrage de nginx 4 fois par heure sans raison.

On désire plutôt ne relancer/recharger le service que lorsque la configuration conrespondante a été modifiée. c’est l’objet des tâches spéciales nommées handlers.

Ajoutez une section handlers: à la suite

Déplacez la tâche de redémarrage/reload de nginx dans cette section et mettez comme nom reload nginx.

Ajoutez aux deux tâches de modification de la configuration la directive notify: <nom_du_handler>.

Testez votre playbook. Il devrait être idempotent sauf le restart de hello.service.

Testez le handler en ajoutant un commentaire dans le fichier de configuration nginx.conf.j2.

- name: template nginx site config

template:

src: templates/nginx.conf.j2

dest: /etc/nginx/sites-available/{{ app.domain }}.conf

notify: reload nginx

...

handlers:

- name: reload nginx

systemd:

name: "nginx"

state: reloaded

# => penser aussi à supprimer la tâche de restart de nginx précédente

Plutôt qu’une variable app unique on voudrait fournir au playbook une liste d’application à installer (liste potentiellement définie durant l’exécution).

Identifiez dans le playbook précédent les tâches qui sont exactement communes aux deux installations.

Créez un nouveau fichier deploy_app_tasks.yml et copier à l’intérieur la liste de toutes les autres tâches mais sans les handlers que vous laisserez à la fin du playbook.

Ce nouveau fichier n’est pas à proprement parler un playbook mais une liste de tâches. utilisez include_tasks: pour importer cette liste de tâche à l’endroit ou vous les avez supprimées.

Vérifiez que le playbook fonctionne et est toujours idempotent.

Ajoutez une tâche debug: msg={{ app }} au début du playbook pour visualiser le contenu de la variable.

Ensuite remplacez la variable app par une liste flask_apps de deux dictionnaires (avec name, domain, user différents les deux dictionnaires et repository et version identiques).

flask_apps:

- name: hello

domain: "hello.test"

user: "flask1"

version: master

repository: https://github.com/e-lie/flask_hello_ansible.git

- name: hello2

domain: "hello2.test"

user: "flask2"

version: master

repository: https://github.com/e-lie/flask_hello_ansible.git

Utilisez les directives loop et loop_control+loop_var sur la tâche include_tasks pour inclure les tâches pour chacune des deux applications.

Créez le dossier group_vars et déplacez le dictionnaire flask_apps dans un fichier group_vars/appservers.yml. Comme son nom l’indique ce dossier permet de définir les variables pour un groupe de serveurs dans un fichier externe.

Testez en relançant le playbook que le déplacement des variables est pris en compte correctement.

tp2_correction avec git checkout tp2_correction.Le dépôt contient également les corrigés du TP3 et TP4 dans d’autre branches.

Vous pouvez consultez la correction également directement sur le site de github.

Pour ceux ou celles qui sont allé-es vite, vous pouvez tenter de créer une nouvelle version de votre playbook portable entre CentOS et ubuntu. Pour cela utilisez la directive when: ansible_os_family == 'Debian' ou RedHat.

Essayez de déployer une version plus complexe d’application flask avec une base de donnée mysql: https://github.com/miguelgrinberg/microblog/tree/v0.17

Il s’agit de l’application construite au fur et à mesure dans un super tutoriel Python sur Flask. Ce chapitre indique comment déployer l’application sur linux.

tp3_provisionner_roles.Dans notre infra virtuelle, nous avons trois machines dans deux groupes. Quand notre lab d’infra grossit il devient laborieux de créer les machines et affecter les ip à la main. En particulier détruire le lab et le reconstruire est pénible. Nous allons pour cela introduire un playbook de provisionning qui va créer les conteneurs lxd en définissant leur ip à partir de l’inventaire.

[all:vars]

ansible_user=<votre_user>

[appservers]

app1 ansible_host=10.x.y.121 container_image=ubuntu_ansible node_state=started

app2 ansible_host=10.x.y.122 container_image=ubuntu_ansible node_state=started

[dbservers]

db1 ansible_host=10.x.y.131 container_image=ubuntu_ansible node_state=started

Remplacez x et y dans l’adresse IP par celle fournies par votre réseau virtuel lxd (faites lxc list et copier simplement les deux chiffres du milieu des adresses IP)

Ajoutez un playbook provision_lxd_infra.yml dans un dossier provisionners contenant:

- hosts: localhost

connection: local

tasks:

- name: Setup linux containers for the infrastructure simulation

lxd_container:

name: "{{ item }}"

state: "{{ hostvars[item]['node_state'] }}"

source:

type: image

alias: "{{ hostvars[item]['container_image'] }}"

profiles: ["default"]

config:

security.nesting: 'true'

security.privileged: 'false'

devices:

# configure network interface

eth0:

type: nic

nictype: bridged

parent: lxdbr0

# get ip address from inventory

ipv4.address: "{{ hostvars[item].ansible_host }}"

# Comment following line if you installed lxd using apt

url: unix:/var/snap/lxd/common/lxd/unix.socket

wait_for_ipv4_addresses: true

timeout: 600

register: containers

loop: "{{ groups['all'] }}"

# Uncomment following if you want to populate hosts file pour container local hostnames

# AND launch playbook with --ask-become-pass option

# - name: Config /etc/hosts file accordingly

# become: yes

# lineinfile:

# path: /etc/hosts

# regexp: ".*{{ item }}$"

# line: "{{ hostvars[item].ansible_host }} {{ item }}"

# state: "present"

# loop: "{{ groups['all'] }}"

Etudions le playbook (explication démo).

Lancez le playbook avec sudo car lxd se contrôle en root sur localhost: sudo ansible-playbook provision_lxd_infra (c’est le seul cas exceptionnel ou ansible-playbook doit être lancé avec sudo, pour les autre playbooks ce n’est pas le cas)

Lancez lxc list pour afficher les nouvelles machines de notre infra et vérifier que le serveur de base de données a bien été créé.

roles dans lequel seront rangés tous les rôles (c’est une convention Ansible à respecter).flaskapp dans roles.flaskapp

├── defaults

│ └── main.yml

├── handlers

│ └── main.yml

├── tasks

│ ├── deploy_app_tasks.yml

│ └── main.yml

└── templates

├── app.service.j2

└── nginx.conf.j2

defaults/main.yml permet de définir des valeurs par défaut pour les variables du rôle. Mettez à l’intérieur une application par défaut :flask_apps:

- name: defaultflask

domain: defaultflask.test

repository: https://github.com/e-lie/flask_hello_ansible.git

version: master

user: defaultflask

Ces valeurs seront écrasées par celles fournies dans le dossier group_vars (la liste de deux applications du TP2). Elle est présente pour que le rôle fonctionne même en l’absence de variable (valeurs de fallback).

Copiez les tâches (juste la liste de tirets sans l’intitulé de section tasks:) contenues dans le playbook appservers dans le fichier tasks/main.yml.

De la même façon, copiez le handler dans handlers/main.yml sans l’intitulé handlers:.

Copiez également le fichier deploy_flask_tasks.yml dans le dossier tasks.

Déplacez vos deux fichiers de template dans le dossier templates du rôle (et non celui à la racine que vous pouvez supprimer).

Pour appeler notre nouveau rôle, supprimez les sections tasks: et handlers: du playbook appservers.yml et ajoutez à la place:

roles:

- flaskapp

appservers.yml et debuggez le résultat le cas échéant.tp3_correction avec git checkout tp3_correction.Il contient également les corrigés du TP2 et TP4 dans d’autres branches.

Essayez différents exemples de projets de Geerlingguy accessibles sur GitHub à l’adresse https://github.com/geerlingguy/ansible-for-devops.

tp4_correction avec git checkout tp4_correction.Pour configurer notre infrastructure:

Installez les rôles avec ansible-galaxy install -r roles/requirements.yml -p roles.

Si vous n’avez pas fait la partie Terraform:

./inventory.cfg comme pour les TP précédentssudo ansible-playbook provisionner/provision_lxd_infra.ymlLancez le playbook global site.yml

Utilisez la commande ansible-inventory --graph pour afficher l’arbre des groupes et machines de votre inventaire

Utilisez la de même pour récupérer l’ip du balancer0 (ou balancer1) avec : ansible-inventory --host=balancer0

Ajoutez hello.test et hello2.test dans /etc/hosts pointant vers l’ip de balancer0.

Chargez les pages hello.test et hello2.test.

Observons ensemble l’organisation du code Ansible de notre projet.

balancers.ymlupgrade_apps.yml permet de mettre à jour l’application en respectant sa haute disponibilité. Il s’agit d’une opération d’orchestration simple en les 3 serveurs de notre infrastructure.serial qui permet de d’exécuter séquentiellement un play sur un fraction des serveurs d’un groupe (ici 1 à la fois parmis les 2).delegate qui permet d’exécuter une tâche sur une autre machine que le groupe initialement ciblé. Cette directive est au coeur des possibilités d’orchestration Ansible en ce qu’elle permet de contacter un autre serveur ( déplacement latéral et non pas master -> node ) pour récupérer son état ou effectuer une modification avant de continuer l’exécution et donc de coordonner des opérations.exclude_backend.yml qui permet de sortir un backend applicatif du pool. Il s’utilise avec des variables en ligne de commandeDésactivez le noeud qui vient de vous servir la page en utilisant le playbook exclude_backend.yml:

ansible-playbook --extra-vars="backend_name=<noeud a desactiver> backend_state=disabled" playbooks/exclude_backend.yml

Rechargez la page: vous constatez que c’est l’autre backend qui a pris le relais.

Nous allons maintenant mettre à jour

Créer et manipuler des conteneurs

Une abstraction qui ouvre de nouvelles possibilités pour la manipulation logicielle.

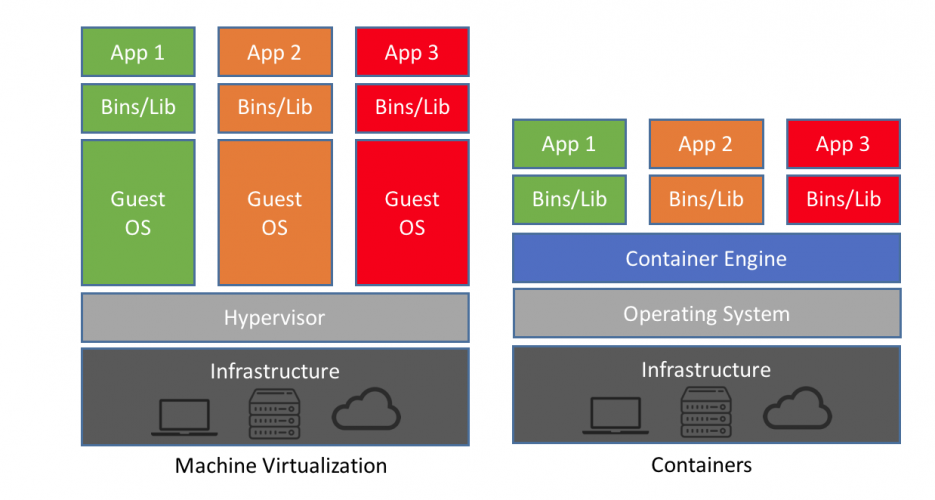

Permet de standardiser et de contrôler la livraison et le déploiement.

On compare souvent les conteneurs aux machines virtuelles. Mais ce sont de grosses simplifications parce qu’on en a un usage similaire : isoler des programmes dans des “contextes”. Une chose essentielle à retenir sur la différence technique : les conteneurs utilisent les mécanismes internes du _kernel de l’OS Linux_ tandis que les VM tentent de communiquer avec l’OS (quel qu’il soit) pour directement avoir accès au matériel de l’ordinateur.

VM : une abstraction complète pour simuler des machines

conteneur : un découpage dans Linux pour séparer des ressources (accès à des dossiers spécifiques sur le disque, accès réseau).

Les deux technologies peuvent utiliser un système de quotas pour l’accès aux ressources matérielles (accès en lecture/écriture sur le disque, sollicitation de la carte réseau, du processeur)

Si l’on cherche la définition d’un conteneur :

C’est un groupe de processus associé à un ensemble de permissions.

L’imaginer comme une “boîte” est donc une allégorie un peu trompeuse, car ce n’est pas de la virtualisation (= isolation au niveau matériel).

Les conteneurs mettent en œuvre un vieux concept d’isolation des processus permis par la philosophie Unix du “tout est fichier”.

chroot, jail, les 6 namespaces et les cgroupschrootchroot [change root : changer de racine], présent dans les systèmes UNIX depuis longtemps (1979 !) :

“Comme tout est fichier, changer la racine d’un processus, c’est comme le faire changer de système”.

jailjail est introduit par FreeBSD en 2002 pour compléter chroot et qui permet pour la première fois une isolation réelle (et sécurisée) des processus.

chroot ne s’occupait que de l’isolation d’un process par rapport au système de fichiers :

En 2005, Sun introduit les conteneurs Solaris décrits comme un « chroot sous stéroïdes » : comme les jails de FreeBSD

Les namespaces, un concept informatique pour parler simplement de…

jail était une façon de compléter chroot, pour FreeBSD.

Pour Linux, ce concept est repris via la mise en place de namespaces Linux

Les conteneurs ne sont finalement que plein de fonctionnalités Linux saucissonnées ensemble de façon cohérente.

Les namespaces correspondent à autant de types de compartiments nécessaires dans l’architecture Linux pour isoler des processus.

Pour la culture, 6 types de namespaces :

Après, il reste à s’occuper de limiter la capacité d’un conteneur à agir sur les ressources matérielles :

En 2005, Google commence le développement des cgroups : une façon de tagger les demandes de processeur et les appels systèmes pour les grouper et les isoler.

:(){ : | :& }; :

Ceci est une fork bomb. Dans un conteneur non privilégié, on bloque tout Docker, voire tout le système sous-jacent, en l’empêchant de créer de nouveaux processus.

Pour éviter cela il faudrait limiter la création de processus via une option kernel.

Ex: docker run -it --ulimit nproc=3 --name fork-bomb bash

L’isolation des conteneurs n’est donc ni magique, ni automatique, ni absolue ! Correctement paramétrée, elle est tout de même assez robuste, mature et testée.

On revient à notre définition d’un conteneur :

1 container = 1 groupe de process Linux

- des namespaces (séparation entre ces groups)

- des cgroups (quota en ressources matérielles)

En 2008 démarre le projet LXC qui chercher à rassembler :

Originellement, Docker était basé sur LXC. Il a depuis développé son propre assemblage de ces 3 mécanismes.

En 2013, Docker commence à proposer une meilleure finition et une interface simple qui facilite l’utilisation des conteneurs LXC.

Puis il propose aussi son cloud, le Docker Hub pour faciliter la gestion d’images toutes faites de conteneurs.

Au fur et à mesure, Docker abandonne le code de LXC (mais continue d’utiliser le chroot, les cgroups et namespaces).

Le code de base de Docker (notamment runC) est open source : l'Open Container Initiative vise à standardiser et rendre robuste l’utilisation de containers.

Docker permet de faire des “quasi-machines” avec des performances proches du natif.

VM et conteneurs proposent une flexibilité de manipulation des ressources de calcul mais les machines virtuelles sont trop lourdes pour être multipliées librement :

Les VM se rapprochent plus du concept de “boite noire”: l’isolation se fait au niveau du matériel et non au niveau du noyau de l’OS.

même si une faille dans l’hyperviseur reste possible car l’isolation n’est pas qu’uniquement matérielle

Les VM sont-elles “plus lentes” ? Pas forcément.

La comparaison VM / conteneurs est un thème extrêmement vaste et complexe.

Docker est pensé dès le départ pour faire des conteneurs applicatifs :

isoler les modules applicatifs.

gérer les dépendances en les embarquant dans le conteneur.

se baser sur l'immutabilité : la configuration d’un conteneur n’est pas faite pour être modifiée après sa création.

avoir un cycle de vie court -> logique DevOps du “bétail vs. animal de compagnie”

Docker modifie beaucoup la “logistique” applicative.

uniformisation face aux divers langages de programmation, configurations et briques logicielles

installation sans accroc et automatisation beaucoup plus facile

permet de simplifier l'intégration continue, la livraison continue et le déploiement continu

rapproche le monde du développement des opérations (tout le monde utilise la même technologie)

Permet l’adoption plus large de la logique DevOps (notamment le concept d’infrastructure as code)

Docker est la technologie ultra-dominante sur le marché de la conteneurisation

LXC existe toujours et est très agréable à utiliser, notamment avec LXD (développé par Canonical, l’entreprise derrière Ubuntu).

Apache Mesos : un logiciel de gestion de cluster qui permet de se passer de Docker, mais propose quand même un support pour les conteneurs OCI (Docker) depuis 2016.

Podman : une alternative à Docker qui utilise la même syntaxe que Docker pour faire tourner des conteneurs OCI (Docker) qui propose un mode rootless et daemonless intéressant.

systemd-nspawn : technologie de conteneurs isolés proposée par systemd

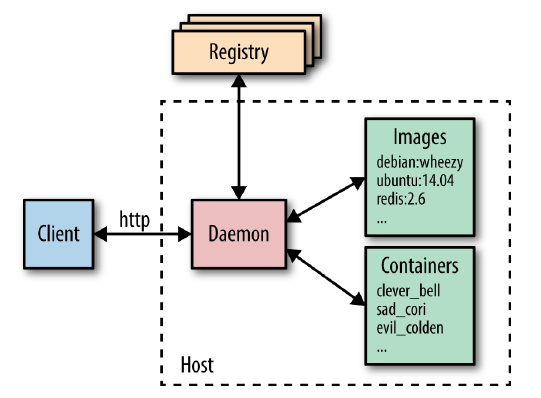

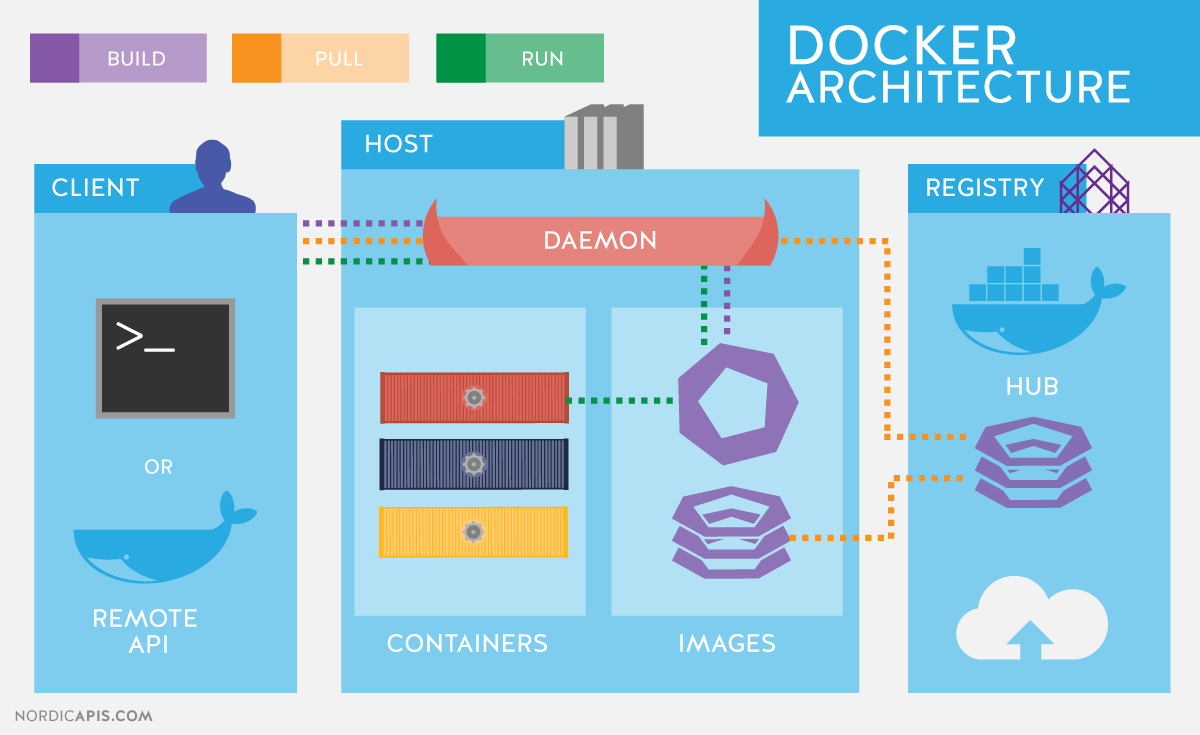

Deux concepts centraux :

Autres concepts primordiaux :

Docker Compose : Un outil pour décrire des applications multiconteneurs.

Docker Machine : Un outil pour gérer le déploiement Docker sur plusieurs machines depuis un hôte.

Docker Hub : Le service d’hébergement d’images proposé par Docker Inc. (le registry officiel)

Docker Engine pour lancer des commandes docker

Docker Compose pour lancer des application multiconteneurs

Portainer, un GUI Docker

VirtualBox pour avoir une VM Linux quand on est sur Windows

Docker est basé sur le noyau Linux :

Quatre possibilités :

Solution WSL2 : on utilise Docker Desktop WSL2:

Solution Windows : on utilise Docker Desktop for Windows:

Solution VirtualBox : on utilise Docker Engine dans une VM Linux

Solution legacy : on utilise Docker Toolbox pour configurer Docker avec le driver VirtualBox :

Pas de virtualisation nécessaire car Docker (le Docker Engine) utilise le noyau du système natif.

On peut l’installer avec le gestionnaire de paquets de l’OS mais cette version peut être trop ancienne.

Sur Ubuntu ou CentOS la méthode conseillée est d’utiliser les paquets fournis dans le dépôt officiel Docker (vous pouvez avoir des surprises avec la version snap d’Ubuntu).

Docker possède à la fois un module pour lancer les applications (runtime) et un outil de build d’application.

Docker possède à la fois un module pour lancer les applications (runtime) et un outil de build d’application.

Pour lister les images on utilise :

docker images

docker image ls

Docker fonctionne avec des sous-commandes et propose de grandes quantités d’options pour chaque commande.

Utilisez --help au maximum après chaque commande, sous-commande ou sous-sous-commandes

docker image --help

docker info # affiche plein d'information sur l'engine avec lequel vous êtes en contact

docker ps # affiche les conteneurs en train de tourner

docker ps -a # affiche également les conteneurs arrêtés

docker run [-d] [-p port_h:port_c] [-v dossier_h:dossier_c] <image> <commande>

créé et lance le conteneur

--name-d permet* de lancer le conteneur en mode daemon ou détaché et libérer le terminal-p permet de mapper un port réseau entre l’intérieur et l’extérieur du conteneur, typiquement lorsqu’on veut accéder à l’application depuis l’hôte.-v permet de monter un volume partagé entre l’hôte et le conteneur.--rm (comme remove) permet de supprimer le conteneur dès qu’il s’arrête.-it permet de lancer une commande en mode interactif (un terminal comme bash).-a (ou --attach) permet de se connecter à l’entrée-sortie du processus dans le container.Le démarrage d’un conteneur est lié à une commande.

Si le conteneur n’a pas de commande, il s’arrête dès qu’il a fini de démarrer

docker run debian # s'arrête tout de suite

docker run debian echo 'attendre 10s' && sleep 10 # s'arrête après 10s

docker run créé un nouveau conteneur à chaque fois.

docker stop <nom_ou_id_conteneur> # ne détruit pas le conteneur

docker start <nom_ou_id_conteneur> # le conteneur a déjà été créé

docker start --attach <nom_ou_id_conteneur> # lance le conteneur et s'attache à la sortie standard

Les conteneurs sont plus que des processus, ce sont des boîtes isolées grâce aux namespaces et cgroups

Depuis l’intérieur d’un conteneur, on a l’impression d’être dans un Linux autonome.

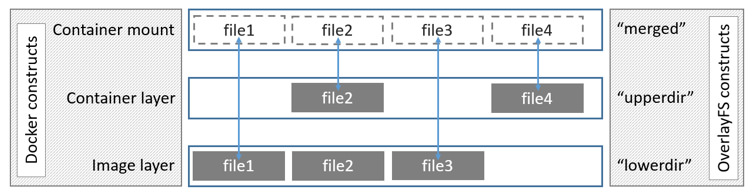

Plus précisément, un conteneur est lié à un système de fichiers (avec des dossiers /bin, /etc, /var, des exécutables, des fichiers…), et possède des métadonnées (stockées en json quelque part par Docker)

Les utilisateurs Unix à l’intérieur du conteneur ont des UID et GID qui existent classiquement sur l’hôte mais ils peuvent correspondre à un utilisateur Unix sans droits sur l’hôte si on utilise les user namespaces.

La commande docker exec permet d’exécuter une commande à l’intérieur du conteneur s’il est lancé.

Une utilisation typique est d’introspecter un conteneur en lançant bash (ou sh).

docker exec -it <conteneur> /bin/bash

Une des forces de Docker vient de la distribution d’images :

pas besoin de dépendances, on récupère une boîte autonome

pas besoin de multiples versions en fonction des OS

Dans ce contexte un élément qui a fait le succès de Docker est le Docker Hub : hub.docker.com

Il s’agit d’un répertoire public et souvent gratuit d’images (officielles ou non) pour des milliers d’applications pré-configurées.

On peut y chercher et trouver presque n’importe quel logiciel au format d’image Docker.

Il suffit pour cela de chercher l’identifiant et la version de l’image désirée.

Puis utiliser docker run [<compte>/]<id_image>:<version>

La partie compte est le compte de la personne qui a poussé ses images sur le Docker Hub. Les images Docker officielles (ubuntu par exemple) ne sont pas liées à un compte : on peut écrire simplement ubuntu:focal.

On peut aussi juste télécharger l’image : docker pull <image>

On peut également y créer un compte gratuit pour pousser et distribuer ses propres images, ou installer son propre serveur de distribution d’images privé ou public, appelé registry.

Accédez à votre VM via l’interface Guacamole

Pour accéder au copier-coller de Guacamole, il faut appuyer sur Ctrl+Alt+Shift et utiliser la zone de texte qui s’affiche (réappuyer sur Ctrl+Alt+Shift pour revenir à la VM).

Pour installer Docker, suivez la documentation officielle pour installer Docker sur Ubuntu, depuis “Install using the repository” jusqu’aux deux commandes sudo apt-get update et sudo apt-get install docker-ce docker-ce-cli containerd.io.

curl -sSL https://get.docker.com | sudo shLancez sudo docker run hello-world. Bien lire le message renvoyé (le traduire sur Deepl si nécessaire). Que s’est-il passé ?

Il manque les droits pour exécuter Docker sans passer par sudo à chaque fois.

rootdockerusermod -aG docker <user> (en remplaçant <user> par ce qu’il faut)sudo reboot puis reconnectez-vous avec Guacamole pour que la modification sur les groupes prenne effet.bash en copiant les commandes suivantes :sudo apt update

sudo apt install bash-completion curl

sudo mkdir /etc/bash_completion.d/

sudo curl -L https://raw.githubusercontent.com/docker/docker-ce/master/components/cli/contrib/completion/bash/docker -o /etc/bash_completion.d/docker.sh

sudo curl -L https://raw.githubusercontent.com/docker/compose/1.24.1/contrib/completion/bash/docker-compose -o /etc/bash_completion.d/docker-compose

Important: Vous pouvez désormais appuyer sur la touche pour utiliser l’autocomplétion quand vous écrivez des commandes Docker

docker info # affiche plein d'information sur l'engine avec lequel vous êtes en contact

docker ps # affiche les conteneurs en train de tourner

docker ps -a # affiche également les conteneurs arrêtés

docker run : https://docs.docker.com/engine/reference/run/Mentalité :

Il faut aussi prendre l’habitude de bien lire ce que la console indique après avoir passé vos commandes.

Il faut aussi prendre l’habitude de bien lire ce que la console indique après avoir passé vos commandes.

Avec l’aide du support et de --help, et en notant sur une feuille ou dans un fichier texte les commandes utilisées :

Lancez un conteneur Debian (docker run puis les arguments nécessaires, cf. l’aide --help) en mode détaché avec la commande echo "Debian container". Rien n’apparaît. En effet en mode détaché la sortie standard n’est pas connectée au terminal.

Lancez docker logs avec le nom ou l’id du conteneur. Vous devriez voir le résultat de la commande echo précédente.

Lancez un conteneur debian en mode détaché avec la commande sleep 3600

Réaffichez la liste des conteneurs qui tournent

Tentez de stopper le conteneur, que se passe-t-il ?

docker stop <conteneur>

NB: On peut désigner un conteneur soit par le nom qu’on lui a donné, soit par le nom généré automatiquement, soit par son empreinte (toutes ces informations sont indiquées dans un docker ps ou docker ps -a). L’autocomplétion fonctionne avec les deux noms.

sleep 3600 en mode détaché).debian_containerLe nom d’un conteneur doit être unique (à ne pas confondre avec le nom de l’image qui est le modèle utilisé à partir duquel est créé le conteneur).

debian2docker run debian -d --name debian2 sleep 500

-i -t) avec la commande /bin/bash et le nom debian_interactif.pull).docker pull nginx

docker run --name "test_nginx" nginx

Ce conteneur n’est pas très utile, car on a oublié de configurer un port ouvert.

nginx créé(s).nginx avec cette fois-ci le port correctement configuré dès le début pour pouvoir visiter votre Nginx en local.docker run -p 8080:80 --name "test2_nginx" nginx # la syntaxe est : port_hote:port_container

On peut lancer des logiciels plus ambitieux, comme par exemple Funkwhale, une sorte d’iTunes en web qui fait aussi réseau social :

docker run --name funky_conteneur -p 80:80 funkwhale/all-in-one:1.0.1

Vous pouvez visiter ensuite ce conteneur Funkwhale sur le port 80 (après quelques secondes à suivre le lancement de l’application dans les logs) ! Mais il n’y aura hélas pas de musique dedans :(

Attention à ne jamais lancer deux containers connectés au même port sur l’hôte, sinon cela échouera !

docker rm -f funky_conteneur